Runpod

综合介绍

Runpod是一个专注于AI开发的云计算平台。它提供按毫秒计费的GPU服务,让开发者可以灵活使用高性能计算资源。这个平台主要面向需要进行机器学习训练和推理的用户。相比传统云服务,它的计费方式更精细,能有效降低开发成本。

平台简化了AI开发流程,用户无需关心底层基础设施。它支持主流深度学习框架,提供预装环境的容器。开发者可以快速启动项目,专注于模型开发本身。Runpod特别适合需要短期使用GPU资源的场景。

功能列表

- 按毫秒计费的GPU云计算服务

- 预配置的AI开发环境容器

- 支持主流深度学习框架

- 快速启动和销毁计算实例

- 实时监控资源使用情况

- 多规格GPU实例选择

- 支持Jupyter Notebook开发

- 团队协作功能

使用帮助

使用Runpod非常简单,不需要复杂的安装过程。首先访问官网注册账号,完成邮箱验证后即可开始使用。

创建第一个实例

登录后点击"New Pod"按钮,系统会显示可选的实例配置。选择适合的GPU型号和内存大小,Runpod提供从入门级到高端的多款GPU选择。

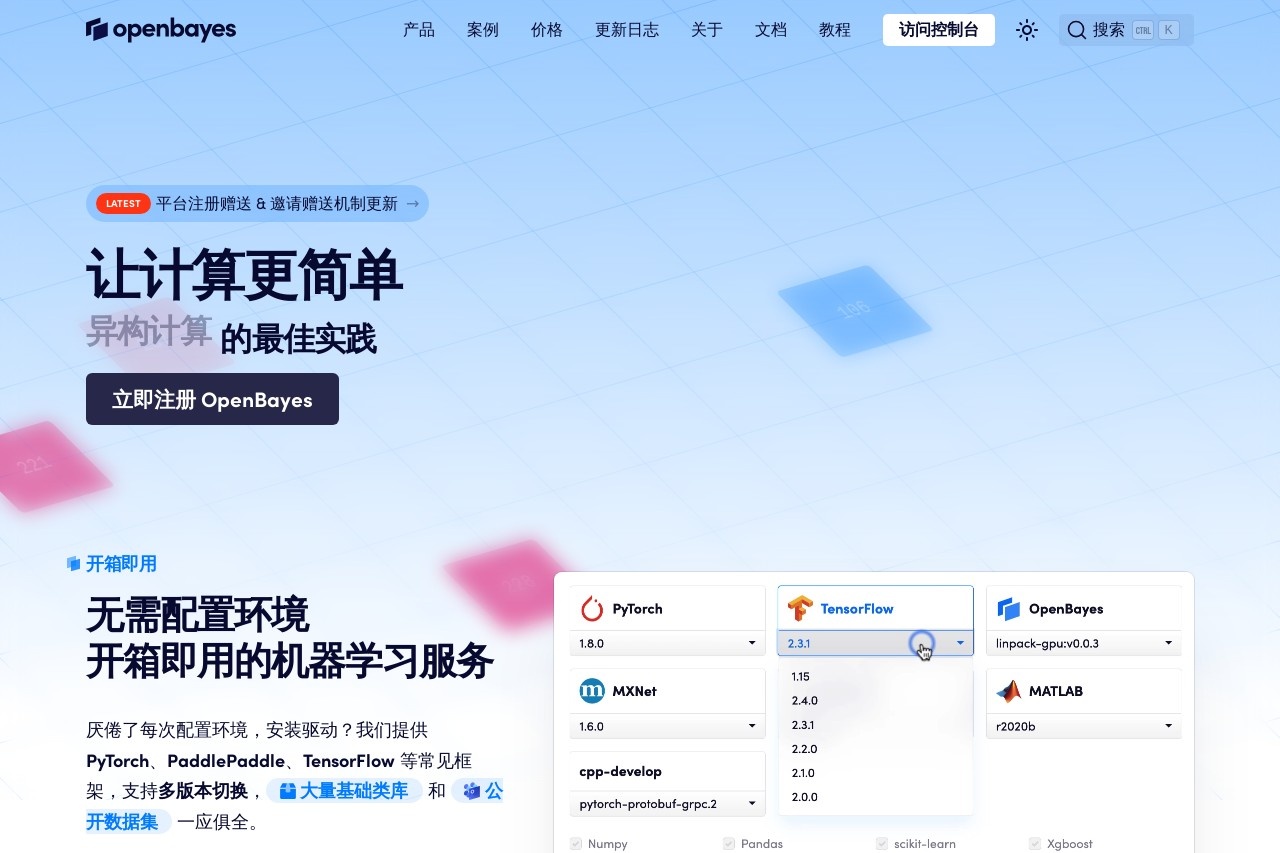

接着选择预装环境。平台提供TensorFlow、PyTorch等主流框架的预配置容器,也支持自定义Docker镜像。选择好后点击"Deploy"按钮,实例将在30秒内启动完成。

开发环境使用

实例启动后,可以通过Web终端或Jupyter Notebook访问。Web终端提供完整的Linux命令行环境,适合有经验的开发者。Jupyter Notebook则更适合交互式开发和调试。

平台会自动挂载持久化存储,确保数据安全。所有修改都会保存在个人存储空间中,即使实例被销毁也不会丢失。

监控和计费

控制面板实时显示GPU使用率和内存占用情况。计费信息也会实时更新,精确到毫秒级别。使用完成后,点击"Stop"按钮立即停止计费。

Runpod支持按需付费和预付费两种模式。按需付费适合短期使用,预付费则能享受更优惠的价格。所有费用明细都可以在账单页面查看。

团队协作

在团队设置中,可以邀请成员加入项目。管理员可以设置不同成员的权限级别,控制对资源的访问。团队成员可以共享实例和存储空间,提高协作效率。

产品特色

Runpod最大的特点是按毫秒计费,让GPU资源使用成本降到最低。

适用人群

- AI研究人员:需要临时使用GPU进行实验和模型训练

- 创业公司:希望降低基础设施成本的AI初创团队

- 学生开发者:学习深度学习需要GPU资源的学生

- 自由职业者:承接AI项目需要灵活计算资源的开发者

应用场景

- 模型训练:短期使用GPU训练机器学习模型

- 算法验证:快速验证新算法的可行性

- 教学演示:在课堂上演示AI模型运行

- 项目投标:为客户制作概念验证原型

常见问题

- 如何计算费用?费用=GPU单价×使用时长。时长精确到毫秒,从实例启动开始计算,到停止为止。

- 数据安全如何保证?所有数据都存储在加密的持久化卷中,只有用户自己可以访问。

- 支持哪些深度学习框架?支持TensorFlow、PyTorch、Keras等主流框架,也支持自定义环境。