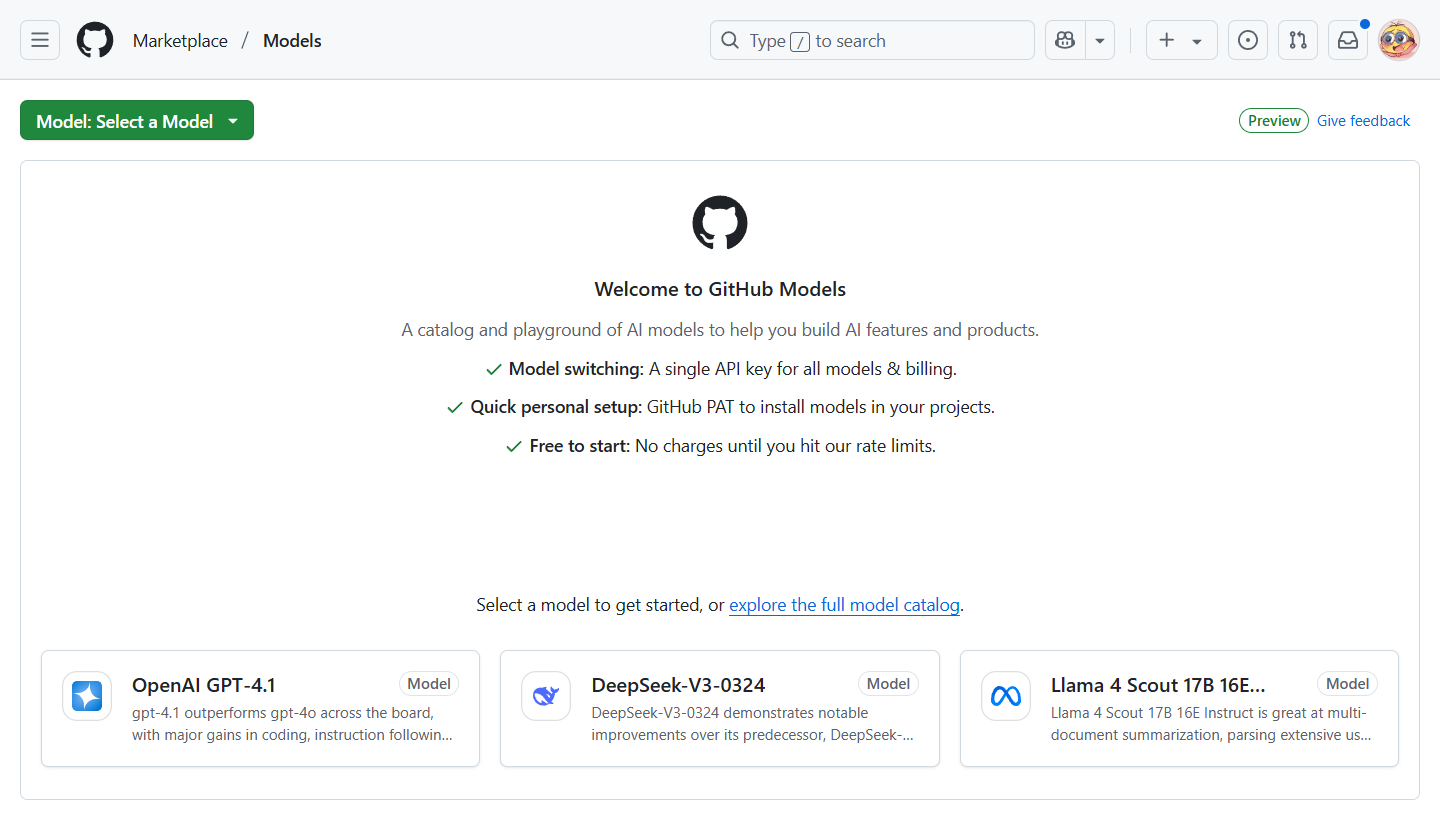

GitHub Models

综合介绍

GitHub Models 是 GitHub 推出的一个免费平台,允许开发者直接在 GitHub 上体验和使用多种人工智能大语言模型(LLM)。这个平台通过简单的界面和 API 调用,让用户可以快速测试和集成模型,如 Llama 3.1、GPT-4o、Phi-3 等。开发者无需创建复杂云资源或下载模型,就能在 GitHub 生态系统中完成 AI 应用的开发。平台支持与 GitHub Codespaces 集成,方便用户在现有代码中调用模型。GitHub Models 适合学生、初学者和专业开发者,目标是降低 AI 开发门槛,帮助用户快速构建 AI 驱动的应用。

功能列表

- 提供多种主流 AI 模型,如 Llama 3.1、GPT-4o、Phi-3、Mistral Large 2 等。

- 支持通过 GitHub Copilot Chat 与模型交互,查看模型列表和推荐。

- 提供代码示例,支持多种编程语言调用 AI 模型。

- 与 GitHub Codespaces 无缝集成,允许在云端开发环境测试模型。

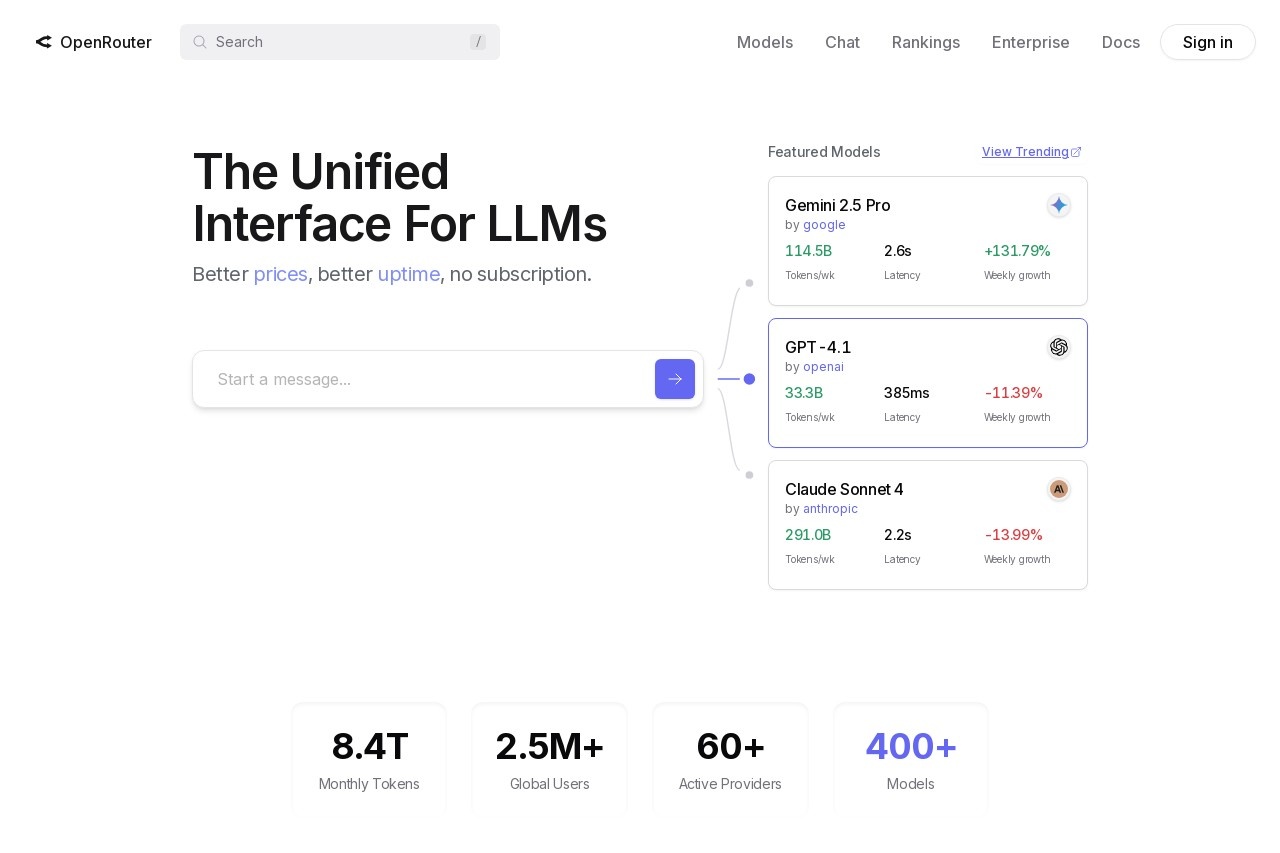

- 支持通过 Azure AI 推理 API 切换模型,无需修改代码。

- 提供 Playground 界面,供用户在线测试模型输出。

- 允许版本控制和协作管理模型相关的 .prompt.yml 文件。

使用帮助

安装与使用流程

GitHub Models 不需要复杂的安装流程。用户只需拥有一个 GitHub 账号即可开始使用。以下是详细的使用步骤:

- 访问 GitHub Models打开浏览器,进入https://gh.io/models。确保已登录 GitHub 账号。如果没有账号,可在 GitHub 官网注册一个免费账号。

- 浏览模型列表在 GitHub Models 页面,点击“Explore Models”或类似按钮,查看支持的模型列表。当前支持的模型包括 Llama 3.1、GPT-4o、GPT-4o mini、Phi-3 等。每个模型页面会显示其功能、参数规模和适用场景。

- 使用 Playground 测试模型GitHub Models 提供一个在线 Playground 界面,允许用户直接输入文本提示(prompt)来测试模型输出。操作步骤如下:

- 选择一个模型,例如 Phi-3-small-8k-instruct。

- 在输入框中输入你的问题或任务,例如“生成一个 Python 函数示例”。

- 点击“Run”或“Submit”按钮,查看模型生成的响应。

- 根据需要调整参数,如

temperature(控制输出随机性)或max_tokens(控制输出长度)。

- 通过 API 集成模型GitHub Models 支持通过 Azure AI 推理 API 调用模型。以下是一个简单的 Python 示例,展示如何调用模型:

import os from azure.ai.inference import ChatCompletionsClient from azure.ai.inference.models import SystemMessage, UserMessage from azure.core.credentials import AzureKeyCredential endpoint = "https://models.inference.ai.azure.com" model_name = "Phi-3-small-8k-instruct" token = os.environ["GITHUB_TOKEN"] client = ChatCompletionsClient( endpoint=endpoint, credential=AzureKeyCredential(token), ) response = client.complete( messages=[ SystemMessage(content="You are a helpful assistant."), UserMessage(content="What is the capital of France?"), ], model=model_name, temperature=1.0, max_tokens=1000, top_p=1.0 ) print(response.choices[0].message.content)- 准备工作:确保已安装 Python 和

azure-ai-inference库(通过pip install azure-ai-inference安装)。 - 获取令牌:在 GitHub 个人设置中生成一个 Personal Access Token,并将其存储为环境变量

GITHUB_TOKEN。 - 运行代码:运行上述代码,模型会返回答案,例如“The capital of France is Paris.”。

- 准备工作:确保已安装 Python 和

- 与 GitHub Codespaces 集成GitHub Models 支持在 Codespaces 中直接运行模型。操作步骤如下:

- 打开 GitHub Codespaces,创建一个新的云端开发环境。

- 在 Codespaces 中打开终端,运行提供的代码示例。

- 调用模型 API,测试模型在代码中的表现。

- Codespaces 的优势是无需本地配置环境,所有操作都在云端完成。

- 通过 Copilot Chat 交互如果你有 GitHub Copilot 订阅,可以通过 Copilot Chat 界面与 GitHub Models 交互。操作步骤:

- 在 GitHub 或 VS Code 中启用 Copilot 扩展。

- 输入命令,如“List all LLMs on GitHub Marketplace” 或“Recommend an LLM for text summarization”。

- Copilot 会返回模型列表或推荐结果,方便选择适合的模型。

- 管理 .prompt.yml 文件GitHub Models 支持将模型提示保存为 .prompt.yml 文件,方便版本控制和团队协作。操作步骤:

- 创建一个 .prompt.yml 文件,定义提示和模型参数。

- 使用 GitHub 的版本控制功能,跟踪文件变更。

- 在团队项目中共享和比较模型输出。

特色功能操作

- 模型切换:通过 Azure AI 推理 API,用户可以在不同模型间切换,无需修改代码。例如,将

model_name从 “Phi-3” 改为 “GPT-4o”,即可使用不同模型。 - Playground 调试:Playground 界面支持实时调整参数。用户可以修改

temperature(0.0 到 1.0,控制输出创意性)或max_tokens(控制输出长度),观察模型响应变化。 - 多语言支持:代码示例支持 Python、JavaScript、Java 等多种语言,开发者可根据需求选择。

注意事项

- 使用 GitHub Models 需要 GitHub 账号和 Personal Access Token。

- 免费计划有使用限额,适合测试和学习。更高限额需订阅 SuperGrok 或 x.com 高级计划。

- Playground 适合快速测试,API 适合生产环境集成。

应用场景

- 学习 AI 模型学生和初学者可以使用 Playground 测试模型,学习如何编写提示和调整参数,无需配置复杂环境。

- 开发 AI 应用开发者可以在现有项目中集成模型 API,构建聊天机器人、代码生成工具或文本分析功能。

- 模型比较团队可以在 GitHub 上比较不同模型的输出,选择最适合任务的模型,例如选择 GPT-4o 用于复杂推理或 Phi-3 用于轻量任务。

- 教育和研究教师和研究人员可以利用 GitHub Models 教授 AI 概念,或在 Codespaces 中进行实验性研究。

QA

- GitHub Models 是否免费?是的,GitHub Models 对所有 GitHub 账号免费开放,但有使用限额。更高限额需订阅付费计划。

- 需要安装什么软件才能使用?无需安装复杂软件。Playground 可直接在浏览器使用,API 调用需要安装相关 SDK(如 Python 的 azure-ai-inference)。

- 如何选择合适的模型?通过 Copilot Chat 输入任务需求,如“推荐适合文本生成的模型”,即可获得推荐。Playground 也支持测试不同模型的输出。

- 支持哪些编程语言?提供 Python、JavaScript、Java 等语言的代码示例,具体见 GitHub Models 文档。