fal

综合介绍

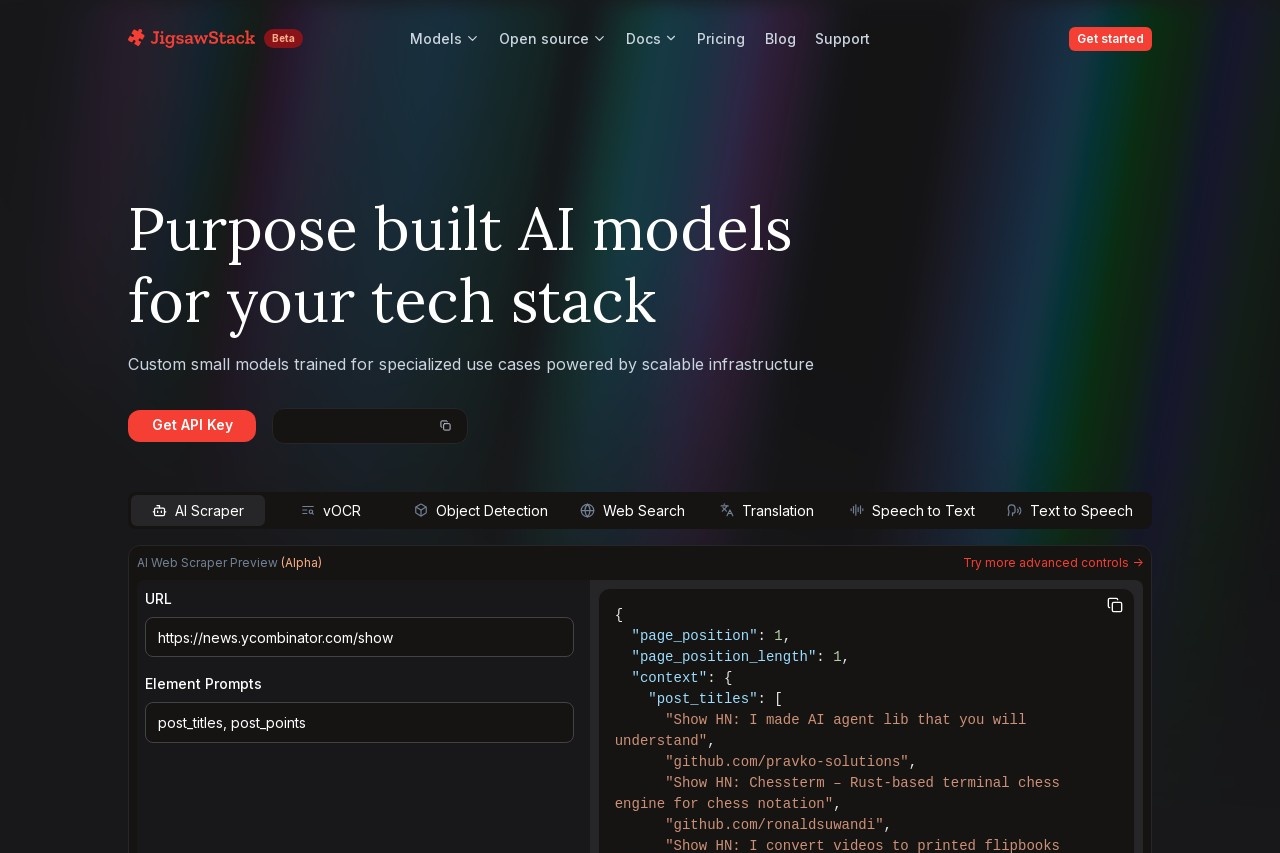

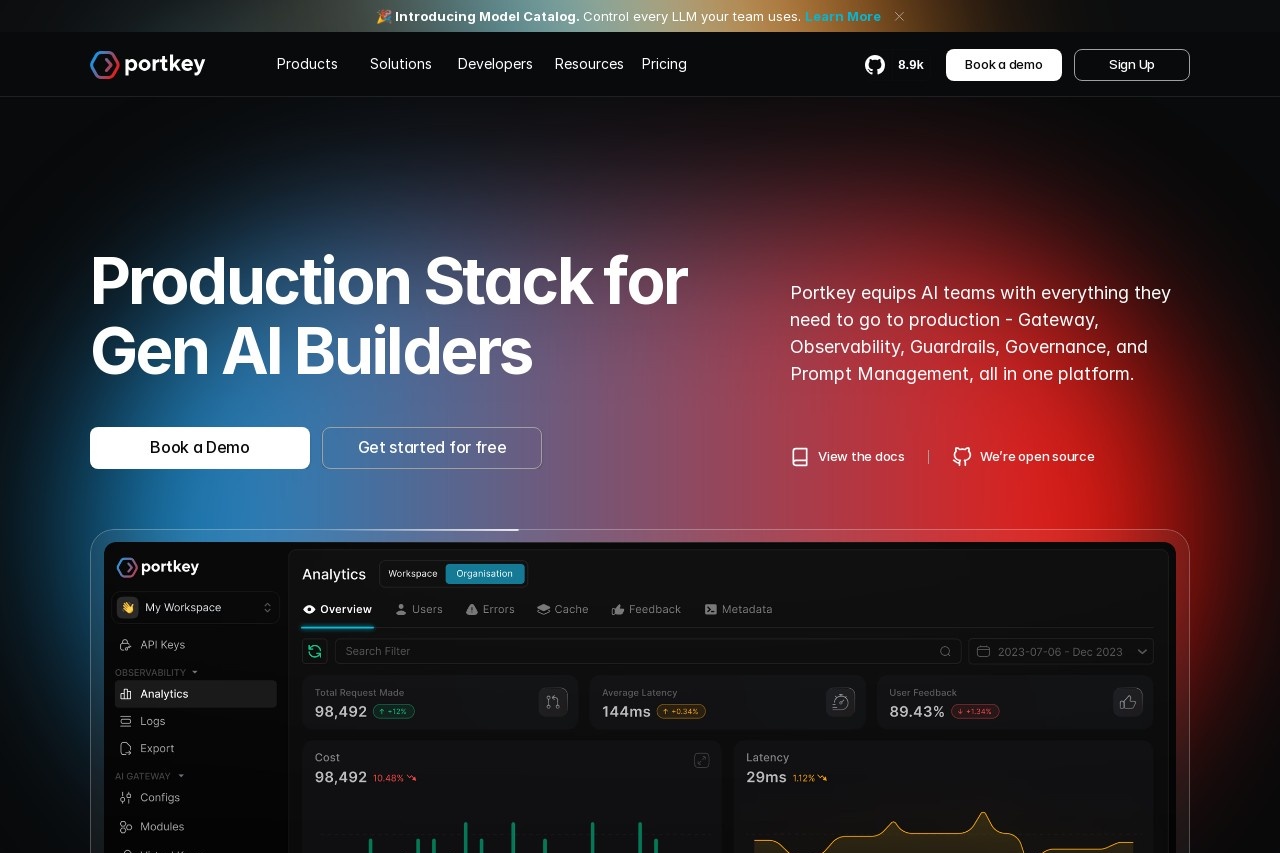

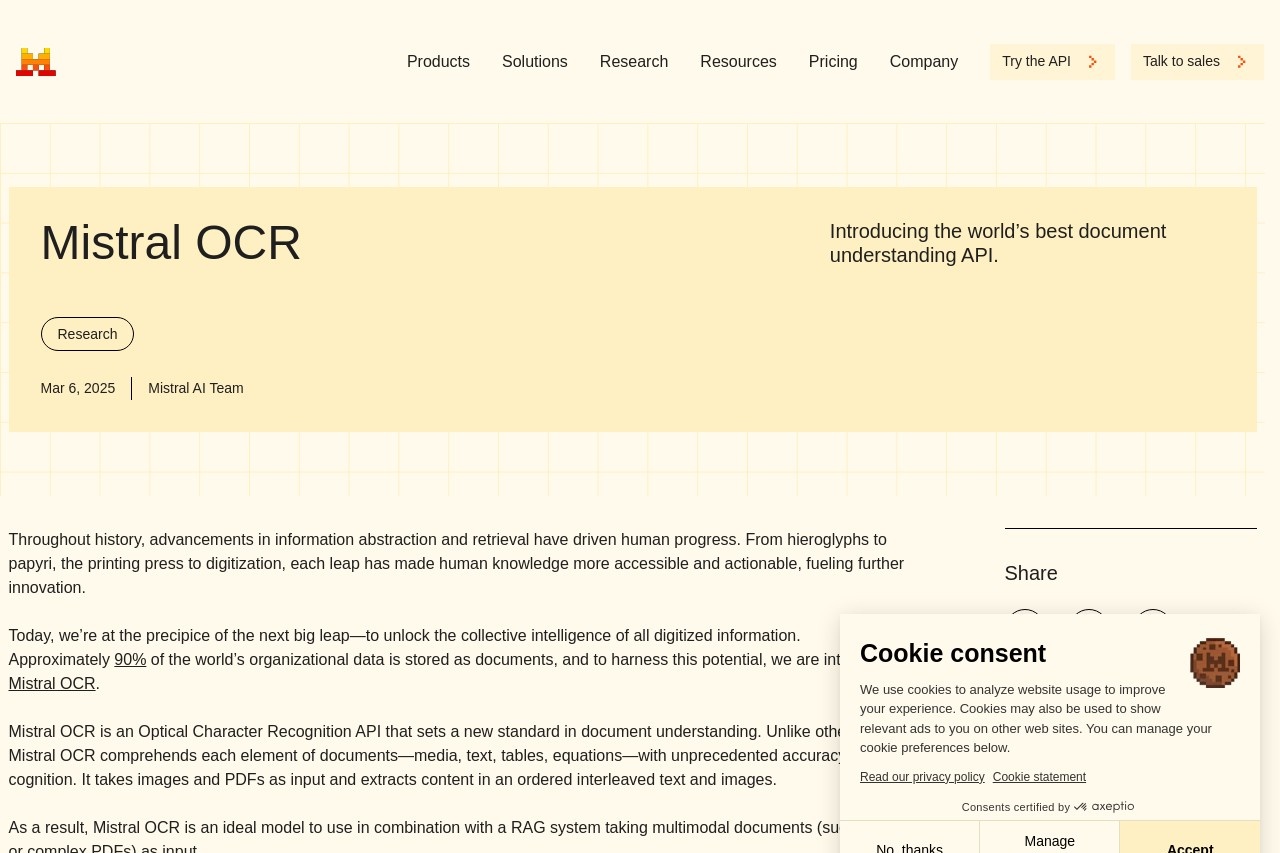

fal.ai 是一个为开发者设计的云平台,其核心目标是简化生成式AI模型的使用和扩展流程。 它提供了一个无服务器计算环境,让开发者可以通过简单的API调用来运行各种复杂的AI模型,例如用于图像生成的Stable Diffusion和FLUX,或是大型语言模型(LLM)。 平台的最大特点是开发者无需管理和维护底层的硬件基础设施,特别是昂贵且复杂的GPU服务器。 fal.ai 采用按使用量付费的模式,根据代码实际运行的计算时间(精确到秒)进行计费,这种方式在没有请求时成本可以降至为零,有效控制了开发和运营成本。 通过这种方式,fal.ai 致力于解决AI开发中的常见痛点,如推理速度慢、部署流程复杂以及应用扩展性差等问题。

功能列表

- 无服务器GPU计算: 提供按需分配的GPU资源,开发者无需购买和管理任何服务器硬件。

- 丰富的模型库: 平台内置了超过150种优化的开源AI模型,涵盖文生图、文生视频、大型语言模型、语音转文本等多种应用场景,例如FLUX、Stable Diffusion 3、LLaMA等。

- 极速推理引擎: 针对深度学习模型(特别是Diffusion模型)进行了性能优化,推理速度最高可提升4倍,适用于需要快速响应的实时应用。

- 支持自定义模型: 开发者不仅可以使用平台提供的预置模型,还可以通过Python函数的形式部署自己的定制模型,在云端环境中运行。

- 灵活的API接口: 提供基于Python、JavaScript和Swift的客户端库,同时也支持标准的REST API调用,方便将其集成到各类网站和移动应用中。

- 实时与异步执行: 支持通过WebSocket进行实时、低延迟的流式推理,也支持提交需要较长处理时间的异步任务。

- LoRA模型训练: 平台支持使用LoRA(Low-Rank Adaptation)技术对模型进行微调,让用户可以用自己的数据快速定制个性化模型。

使用帮助

fal.ai 旨在为开发者提供一个简单、高效的方式来调用和扩展AI模型。下面将详细介绍如何从零开始使用 fal.ai 平台。

第一步:注册与认证

- 创建账户: 首先,你需要访问 fal.ai 官网并注册一个账户。

- 获取API密钥: 登录后,在你的账户设置中创建一个API密钥(API Key)。 这个密钥是你的应用访问 fal.ai 服务的唯一凭证,请务必妥善保管。

- 安装客户端: fal.ai 的主要交互方式是通过其Python客户端库。打开你的终端或命令行工具,使用

pip进行安装:pip install fal - 在本地认证: 安装完成后,运行以下命令进行认证。它会引导你登录账户,并将API密钥保存在本地,方便后续调用。

fal auth login

第二步:运行一个预置模型 (以图像生成为例)

fal.ai 最直接的用法是调用其模型库中已经部署好的模型。这通常只需要几行代码。下面以调用 fal-ai/stable-diffusion-v1-5 模型生成一张图片为例。

- 创建一个Python文件,例如

generate_image.py。 - 在文件中写入以下代码:

import fal # 定义模型的输入参数 # "prompt" 是必须的,定义了你想要生成的图像内容 arguments = { "prompt": "a futuristic cityscape at sunset, cinematic lighting, ultra realistic, 4k" } # 使用 fal.run 调用远程模型 # 第一个参数是模型的标识符 # 第二个参数是模型的输入 result = fal.run( "fal-ai/stable-diffusion-v1-5", arguments=arguments ) # 模型的返回结果通常是一个包含图片URL的字典 image_url = result["images"][0]["url"] print(f"成功生成图片,URL: {image_url}") - 在终端中运行此脚本:

python generate_image.py运行后,你将会在终端看到输出的图片URL。这个URL链接指向的即是AI生成的图片。

第三步:部署自己的Python函数

当你需要的逻辑比单纯调用一个模型更复杂,或者想要运行自己的定制模型时,可以使用 @fal.function 装饰器来部署一个无服务器函数。

- 定义函数: 这个函数和普通的Python函数几乎一样,但需要用

@fal.function装饰器来标记。你可以在装饰器中指定所需的计算资源和依赖库。import fal import requests # 假设我们需要用到 requests 库 # 使用 @fal.function 装饰器 # requirements 指定了该函数运行所需要的Python库 # machine_type 指定了所需的机器类型,例如 'GPU' 或 'L' @fal.function( requirements=["requests", "Pillow"], machine_type="GPU" ) def process_image(image_url: str, text_overlay: str): """ 一个示例函数:下载一张图片,并在上面添加文字。 """ from PIL import Image, ImageDraw, ImageFont import io # 下载图片 response = requests.get(image_url) img_data = response.content image = Image.open(io.BytesIO(img_data)) # 在图片上添加文字 draw = ImageDraw.Draw(image) # 你可能需要提供一个字体文件路径 # font = ImageFont.truetype("arial.ttf", 50) # draw.text((10, 10), text_overlay, fill="white", font=font) draw.text((10, 10), text_overlay, fill="white") # 将处理后的图片保存为字节流并返回 output_buffer = io.BytesIO() image.save(output_buffer, format="PNG") return { "processed_image": output_buffer.getvalue() } # 你可以在本地调用这个函数进行测试,它会在云端执行 # result = process_image.run("https://...", "Hello from Fal!")这个函数被定义后,

fal客户端会自动将其同步到云端。当你在本地代码中调用process_image.run(...)时,函数的代码、依赖和输入参数会被发送到 fal.ai 的服务器上,在指定的GPU机器上执行,然后返回结果。

第四步:创建实时API端点

对于需要低延迟响应的交互式应用(例如聊天机器人、实时图像滤镜),你可以使用 @fal.realtime 来创建一个持久化的API端点。

import fal

# 使用 @fal.realtime 装饰器创建一个实时端点

@fal.realtime

def real_time_endpoint(prompt: str):

# 这里可以调用一个快速的AI模型

# 为了演示,我们直接返回处理后的文本

return {

"response": f"Received prompt: {prompt}"

}

使用 @fal.realtime 部署后,fal.ai 会提供一个可以通过HTTP或WebSocket直接访问的URL。这使得前端应用(例如React或Vue构建的网页)可以直接与你的AI模型进行交互,而无需通过Python后端中转。

应用场景

- 生成式媒体应用开发者可以利用 fal.ai 快速构建以生成式AI为核心的应用,如AI绘画工具、头像生成器、视频片段创作工具等。 由于平台提供了优化的模型和高速推理引擎,这些应用可以实现接近实时的用户体验。

- AI功能集成对于已有的网站或App,可以将 fal.ai 作为AI功能的后端服务。 例如,电商网站可以集成文生图功能来生成商品展示图,社交应用可以集成AI滤镜来处理用户上传的图片。

- 企业级定制化AI工作流企业可以利用 fal.ai 的私有部署功能,将内部数据和定制模型结合,构建复杂的AI工作流。 例如,市场营销团队可以训练一个特定品牌风格的LoRA模型,用于批量生成广告素材。

- 快速原型验证和研究AI研究人员和开发者可以利用该平台快速测试不同模型的性能和效果,而无需投入时间和金钱进行繁琐的环境配置和硬件采购。

QA

- 什么是无服务器GPU (Serverless GPU)?这是一种云计算服务模型,它允许你按需使用GPU计算资源,而无需预先购买、配置或管理任何物理服务器或虚拟机。 你只需上传并运行你的代码,平台会自动分配所需的GPU资源,并在代码执行完毕后释放资源。计费完全基于实际使用时间。

- fal.ai 的收费模式是怎样的?fal.ai 采用按使用量付费的模式。费用主要根据模型运行时所占用的GPU型号和时长(精确到秒)来计算。 当没有代码运行时,不会产生任何费用。部分特定模型也可能根据生成结果的数量或分辨率收费。

- 我可以使用自己的AI模型吗?可以。fal.ai 支持部署自定义模型。 你可以通过

@fal.function装饰器将你的Python代码(包括模型加载和推理逻辑)封装成一个无服务器函数,并指定所需的依赖库和硬件环境。 fal.run和@fal.function有什么区别?fal.run主要用于快速调用平台已经托管的、公开的模型,适合一次性的、简单的任务。 而@fal.function用于定义和部署你自己的、包含更复杂逻辑的Python函数,它为你提供了一个可重复调用和管理的云端执行环境,更适合构建定制化的工作流。