WaterCrawl

综合介绍

WaterCrawl 是一款专为开发者设计的现代网络爬虫框架。它能快速将网站内容转化为结构化数据,大幅提升数据采集效率。无论是企业数据监控、市场调研还是学术研究,WaterCrawl 都能提供稳定可靠的数据抓取解决方案。

该框架采用先进的技术架构,支持分布式爬取和智能反爬策略。开发者可以轻松定制爬取规则,无需担心IP封禁等问题。WaterCrawl 特别适合需要处理大规模网页数据的应用场景。

功能列表

- "智能解析引擎":自动识别网页结构,提取关键数据

- "分布式爬取":支持多节点并行抓取,提高采集速度

- "反反爬机制":内置多种策略绕过网站防护

- "数据清洗":自动过滤无用信息,输出干净数据

- "定时任务":设置自动采集计划,定期更新数据

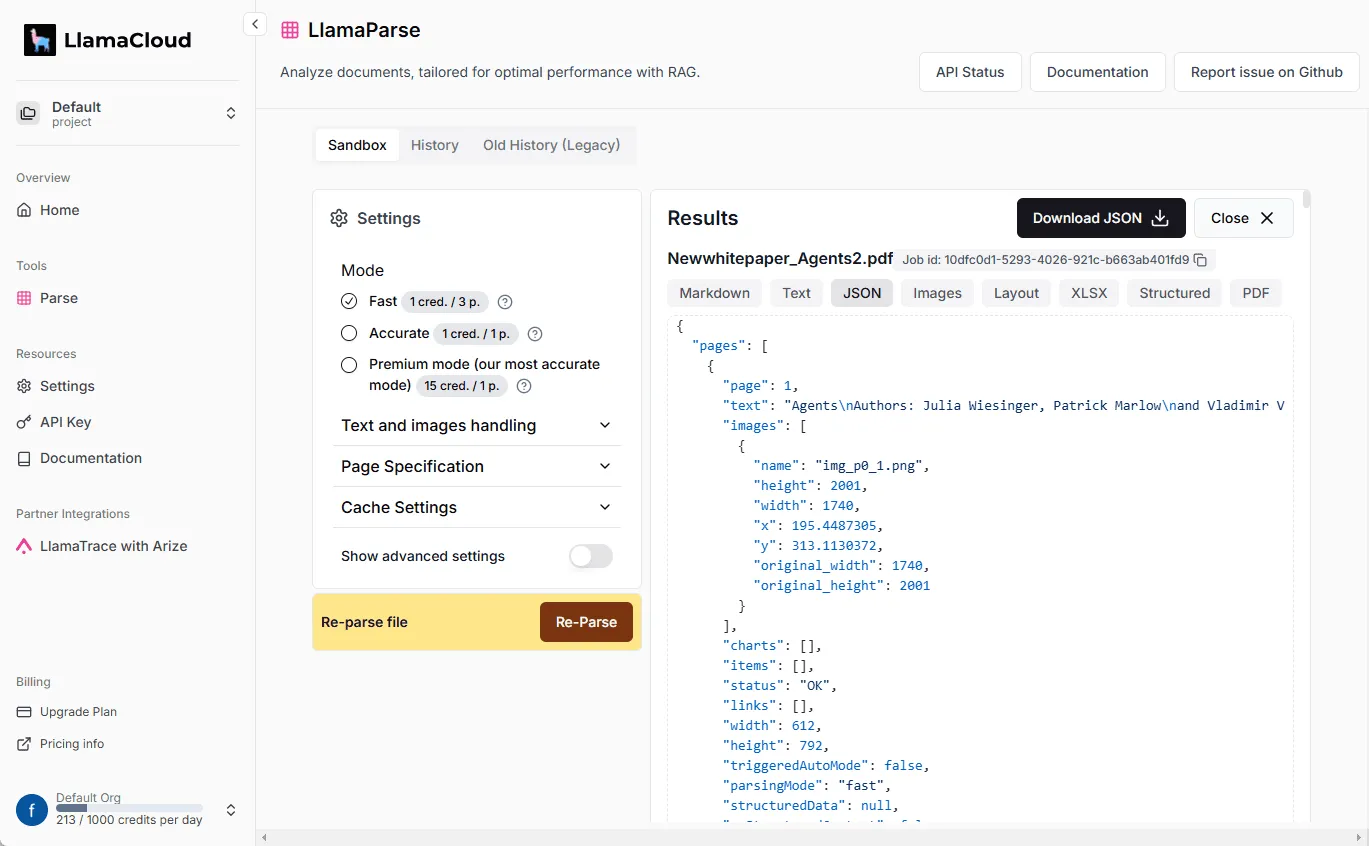

- "API接口":提供RESTful API,方便集成到现有系统

使用帮助

安装WaterCrawl非常简单。如果你使用Python环境,只需运行以下命令:

pip install watercrawl安装完成后,你可以通过几行代码快速开始爬取任务。首先导入必要的模块:

from watercrawl import Spider, Parser创建一个爬虫实例,设置起始URL:

spider = Spider(start_url="https://example.com")定义解析规则。WaterCrawl使用CSS选择器或XPath来定位元素:

parser = Parser(

title="h1",

content=".article-content",

date=".post-date"

)启动爬虫并保存结果:

results = spider.crawl(parser)

results.to_csv("output.csv")对于更复杂的任务,你可以配置爬取深度、请求间隔等参数:

spider.config(

depth=3,

delay=2,

max_pages=100

)WaterCrawl还支持分布式部署。你可以在多台服务器上运行爬虫节点,通过Redis进行任务调度:

spider.distribute(

redis_host="127.0.0.1",

redis_port=6379

)产品特色

简单易用的API设计,让开发者快速实现专业级数据采集。

适用人群

- 开发者:需要采集网页数据的程序员

- 数据分析师:需要大量结构化数据进行分析

- 研究人员:需要自动化收集网络信息

应用场景

- 竞品分析:监控竞争对手产品信息

- 价格监控:跟踪电商平台商品价格变化

- 舆情监测:收集社交媒体和新闻网站内容

常见问题

- 如何避免被封IP? WaterCrawl内置智能延迟和代理轮换机制,可以有效降低被封风险。

- 支持JavaScript渲染的网站吗? 是的,通过配置可以启用无头浏览器模式,支持动态加载内容。

- 数据存储格式有哪些选择? 支持CSV、JSON、MySQL等多种存储格式。