LlamaCloud

综合介绍

LlamaCloud是一个专为大型语言模型(LLM)和检索增强生成(RAG)应用设计的云服务平台。它提供托管解析、数据摄取和检索功能,帮助开发者快速构建生产级的上下文增强应用。

这个平台特别适合需要处理大量文本数据的人工智能项目。通过LlamaCloud,开发者可以轻松地将外部知识整合到语言模型中,显著提升模型的回答质量和准确性。

功能列表

- "托管解析服务":自动解析各种格式的文档,包括PDF、Word和HTML

- "智能数据摄取":高效处理大规模文本数据,支持结构化存储

- "高级检索系统":为RAG应用提供精准的上下文检索功能

- "生产级部署":开箱即用的API接口,支持高并发访问

- "性能监控":实时跟踪系统运行状态和查询性能

使用帮助

要开始使用LlamaCloud,首先需要注册一个账户。访问官网后点击"注册"按钮,填写基本信息即可完成注册。

注册成功后,系统会自动创建一个默认项目。在控制面板中,你可以看到三个主要功能模块:解析、摄取和检索。

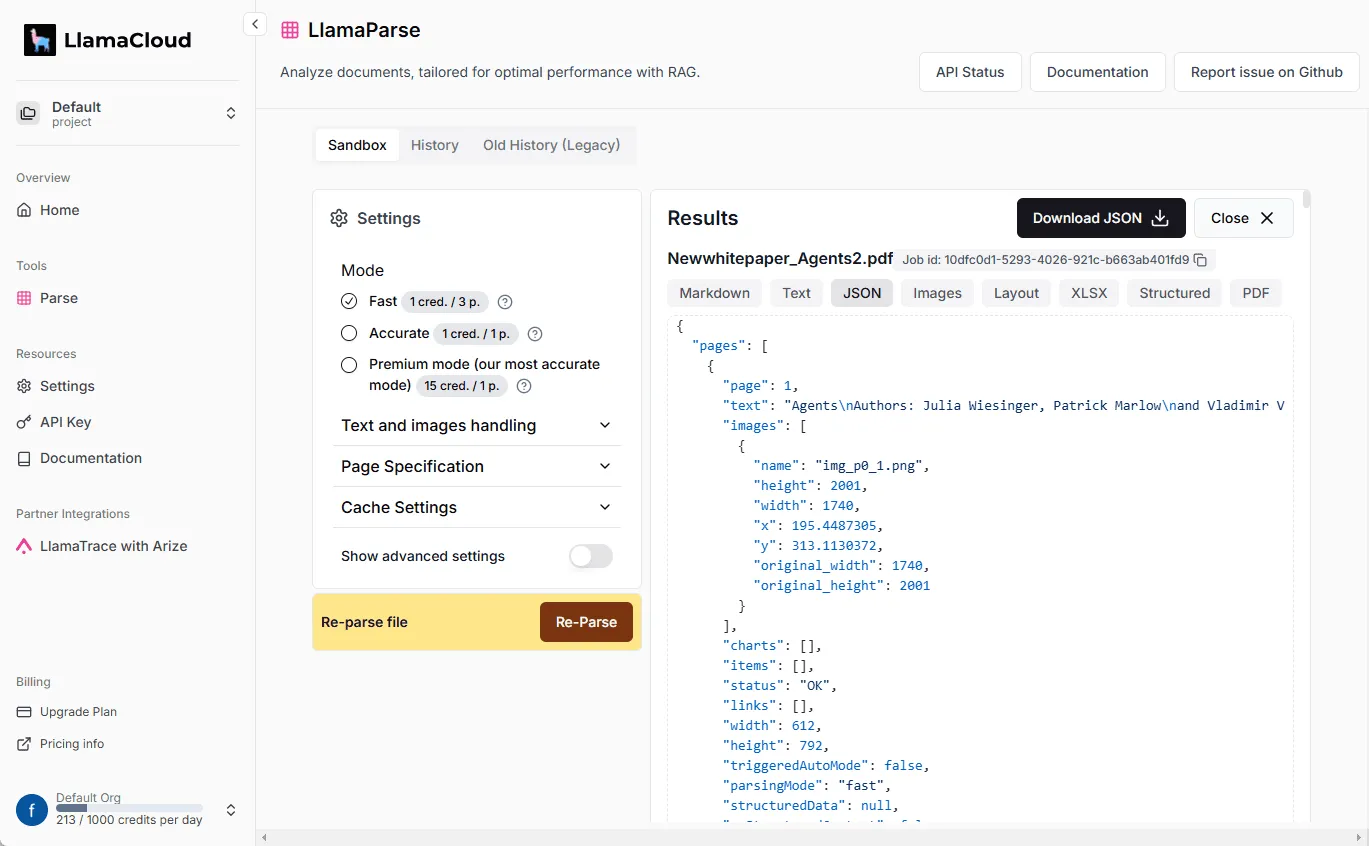

文档解析

点击"解析"选项卡上传你的文档。支持的文件类型包括:

- PDF文档

- Word文档(.docx)

- HTML网页

- 纯文本文件

上传后系统会自动处理文档内容。处理完成后,你可以在"文档库"中查看解析结果。

数据摄取

在"摄取"页面,你可以将解析后的文档导入到知识库中。系统提供两种摄取方式:

- 批量导入:一次性上传多个文档

- 增量更新:只更新修改过的内容

摄取过程可能需要几分钟时间,取决于文档数量。完成后会收到邮件通知。

检索API

LlamaCloud的核心功能是通过API进行知识检索。在"API密钥"页面获取你的专属密钥。

使用Python调用检索API的示例代码:

import requests

url = "https://api.llamacloud.com/v1/retrieve"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"query": "什么是RAG模型",

"top_k": 3

}

response = requests.post(url, headers=headers, json=data)

print(response.json())

API返回的结果包含相关文档片段及其相关性评分,可以直接用于RAG应用。

产品特色

专为LLM和RAG应用优化的生产级上下文增强服务。

适用人群

- AI开发者:需要构建RAG应用的工程师

- 数据科学家:处理大规模文本数据的研究人员

- 企业用户:需要知识增强型AI解决方案的公司

应用场景

- 智能客服系统:为客服机器人提供精准的知识检索

- 研究助手:帮助学者快速查找相关文献

- 企业知识库:构建公司内部的知识管理系统

常见问题

- 如何处理大文件上传?LlamaCloud支持断点续传,网络中断后可以继续上传。单个文件最大支持1GB。

- API调用有限制吗?免费账户每分钟100次调用,付费账户可根据需求调整限额。

- 数据安全性如何保障?所有数据传输都经过加密,可以选择将数据存储在指定区域。