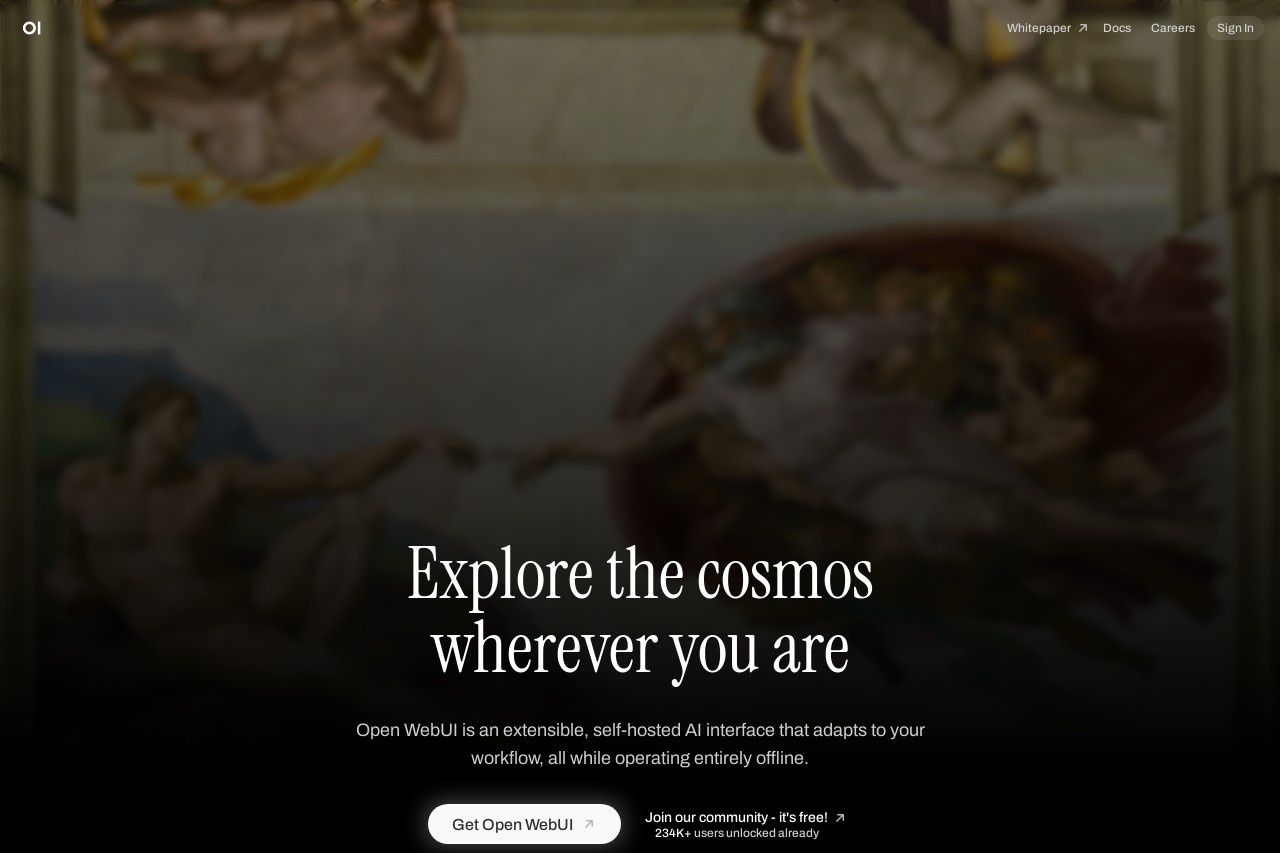

Open WebUI

综合介绍

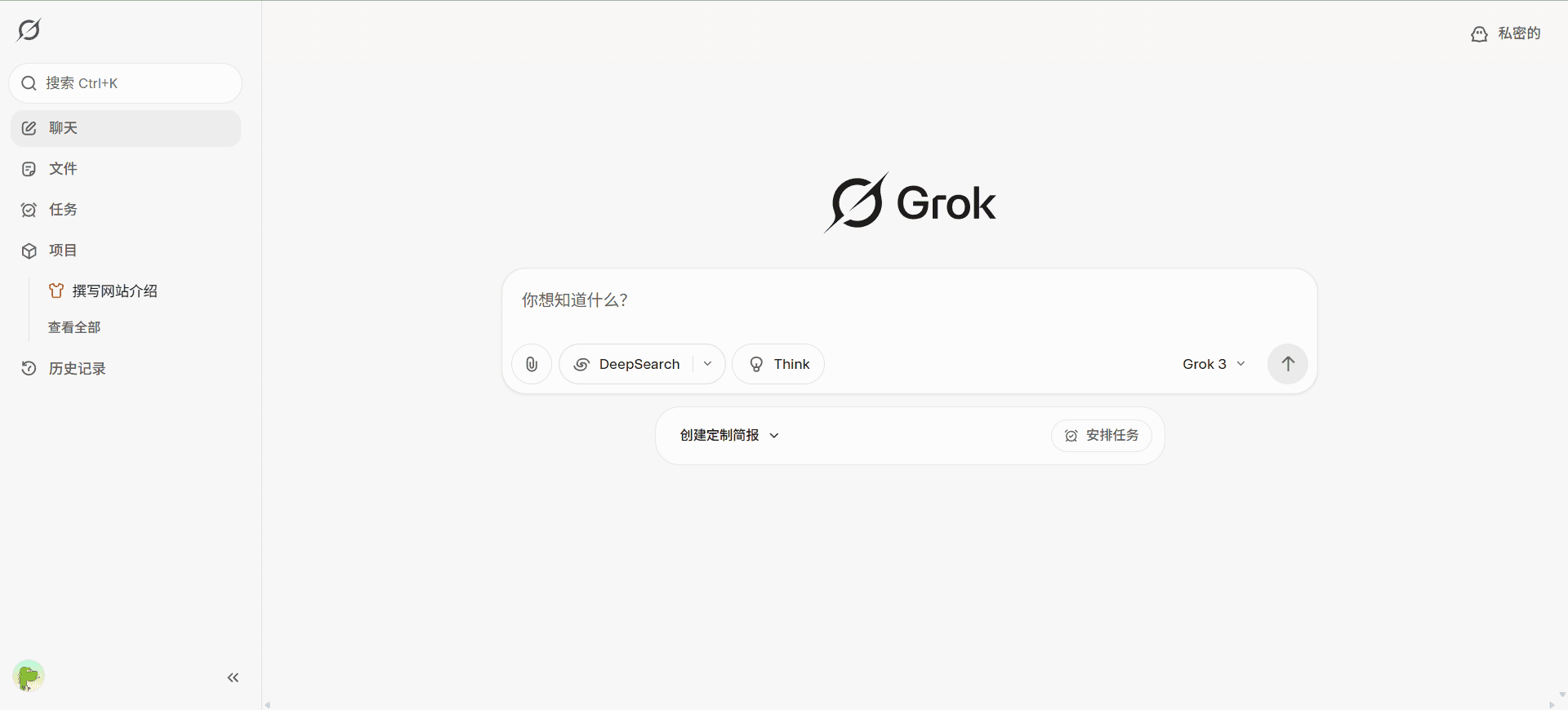

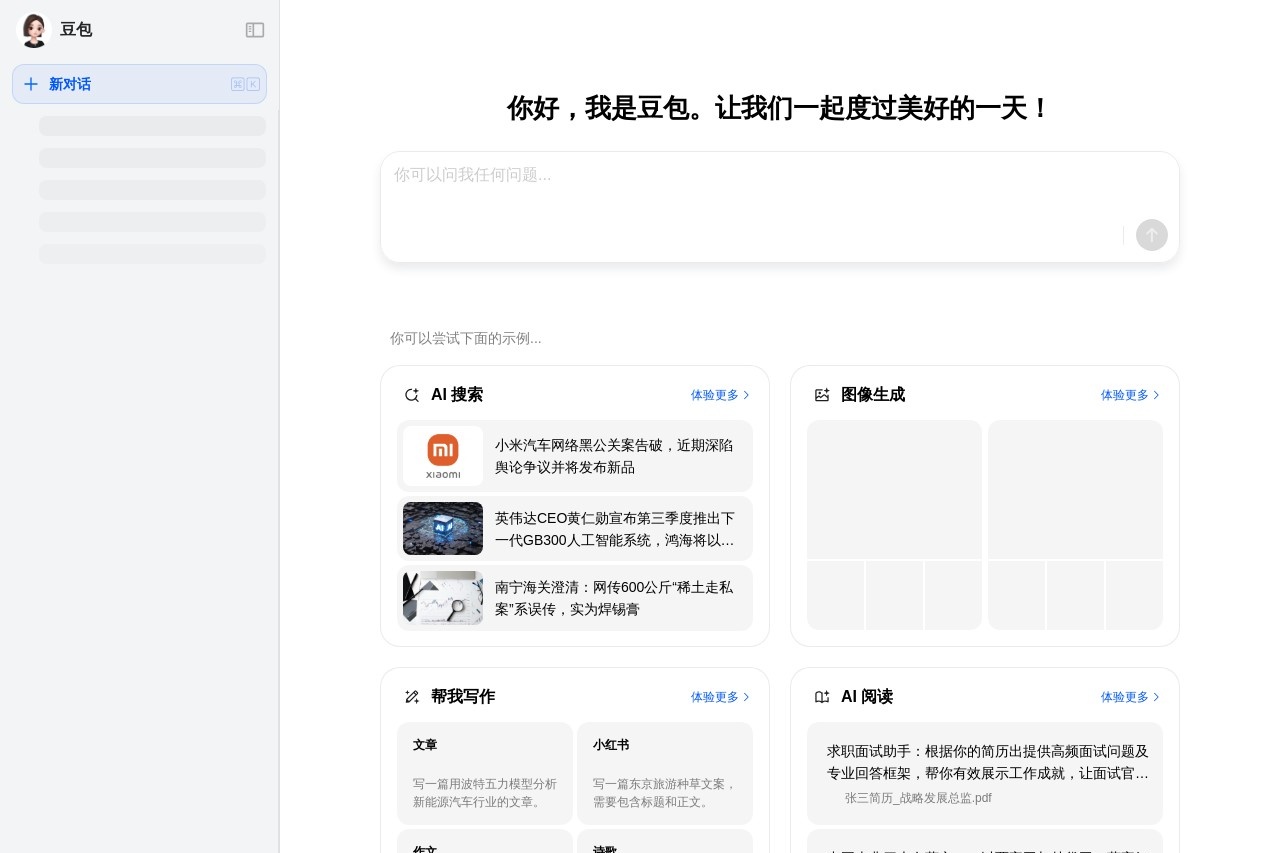

Open WebUI 是一个开源、用户友好的自托管AI交互平台,专为离线运行设计。它支持多种语言模型运行器,如 Ollama 和 OpenAI 兼容的 API,提供强大的 AI 交互功能。用户可以通过简单的界面与 AI 模型进行对话、管理文档并执行复杂任务。平台支持 Docker 和 Kubernetes 部署,安装简单,适合个人和企业使用。Open WebUI 提供语音交互、模型构建和本地 RAG(检索增强生成)功能,满足多样化的 AI 应用需求。它完全开源,遵循修订后的 BSD-3 许可证,保留“Open WebUI”品牌,确保用户可以自由使用和修改。

功能列表

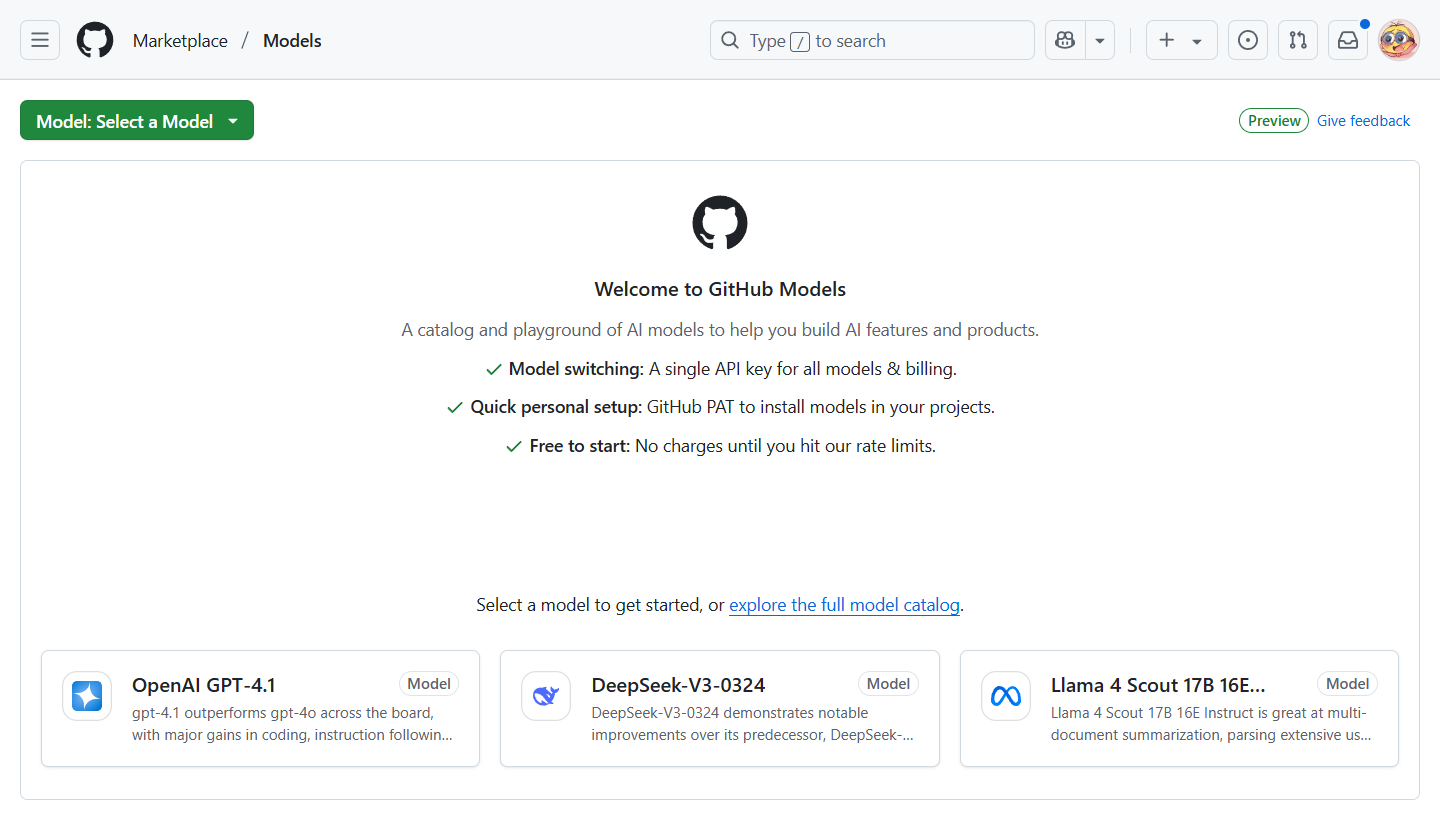

- 支持离线运行的 AI 交互界面,兼容 Ollama 和 OpenAI API。

- 提供语音和视频通话功能,支持免提操作。

- 内置 RAG 功能,可直接加载文档并通过查询检索内容。

- 模型构建工具,允许用户通过界面创建和导入自定义 Ollama 模型。

- 支持 Python 函数调用,允许用户添加自定义函数与模型交互。

- 提供文档库管理,方便用户上传和管理文件。

- 支持多平台部署,包括 Docker、Kubernetes 和本地 Python 安装。

- 提供企业级功能,如自定义主题、SLA 支持和长期支持版本。

使用帮助

安装不支持

Open WebUI 提供多种安装方式,适合不同技术水平的用户。以下是主要安装方法:

Docker 安装

- 确保已安装 Docker。

- 运行以下命令以启动 Open WebUI 容器:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 对于 Nvidia GPU 支持,运行:

docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda - 安装完成后,访问

http://localhost:8080使用平台。

Python 安装

- 确保使用 Python 3.11(推荐使用 uv 或 conda 管理环境)。

- 运行以下命令安装 Open WebUI:

pip install open-webui - 设置数据目录以避免数据丢失,例如:

DATA_DIR=/path/to/data open-webui - 启动后,访问

http://localhost:8080。

主要功能操作

- AI 对话:进入主界面,选择模型(如 Ollama 或 OpenAI API),直接输入问题即可开始对话。支持文本和语音输入,点击麦克风图标启用免提模式。

- RAG 功能:上传文档到文档库,输入查询时使用

#前缀调用文档内容。例如:#filename 查询内容。系统会根据文档内容生成更精准的回答。 - 模型构建:在模型构建页面,选择“创建模型”,输入模型参数或导入现有模型。支持社区模型直接导入,操作简单。

- 语音交互:点击界面上的语音图标,启用麦克风进行免提对话。支持实时语音转文字,适合快速交互。

- Python 函数调用:在工具工作区添加 Python 函数代码,保存后可直接在对话中使用。例如,添加一个计算函数后,可通过对话调用该功能。

- 文档管理:在文档库上传 PDF、TXT 等文件,支持批量上传。文件可通过 RAG 功能直接用于对话或查询。

注意事项

- 确保网络支持 WebSocket 连接,否则可能导致功能异常。

- Docker 安装需包含

-v open-webui:/app/backend/data参数以保存数据。 - Python 安装建议使用虚拟环境,避免依赖冲突。

进阶功能

- 企业级功能:通过企业计划,用户可获得自定义主题、SLA 支持等功能。联系官方销售团队获取详情。

- 社区支持:加入 Open WebUI Discord 社区,获取实时帮助和更新信息。

- 模型优化:定期更新模型以提升性能,参考官方文档的更新指南。

应用场景

- 个人 AI 助手用户可以在本地部署 Open WebUI,作为私人 AI 助手处理日常任务,如文档整理、问题解答或日程管理。离线运行确保数据隐私。

- 企业级 AI 部署企业可通过 Docker 或 Kubernetes 部署 Open WebUI,用于内部知识库管理、客户支持自动化或数据分析。

- 开发者的 AI 实验平台开发者可通过模型构建和 Python 函数调用功能,快速测试和开发自定义 AI 模型,适合研究和原型开发。

- 教育与研究学生和研究人员可利用 RAG 功能分析学术文档,快速提取关键信息,支持论文写作和知识整理。

QA

- Open WebUI 是否需要联网?不需要。Open WebUI 设计为完全离线运行,适合无网络环境。但某些功能(如 OpenAI API)需要联网。

- 支持哪些语言模型?支持 Ollama、OpenAI 兼容 API 以及用户自定义模型。

- 如何确保数据安全?离线运行和自托管模式确保数据存储在本地设备,Docker 安装需正确配置数据卷以防止丢失。

- 是否支持 GPU 加速?是的,使用

:cuda镜像支持 Nvidia GPU 加速,需安装相应驱动。 - 如何获取技术支持?可通过 GitHub 提交问题或加入 Open WebUI Discord 社区获取帮助。