core

综合介绍

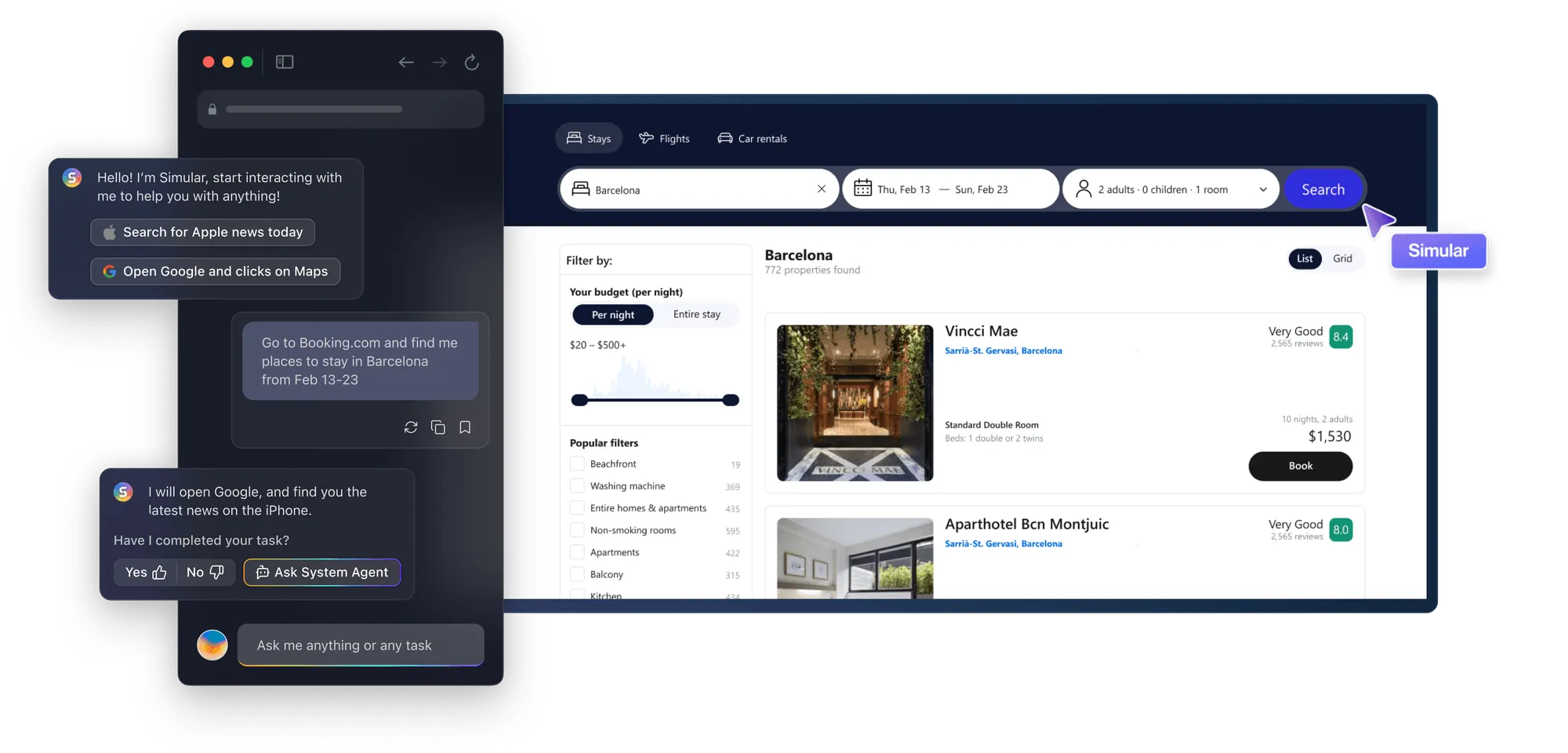

C.O.R.E,全称为“情境观察与回忆引擎”(Contextual Observation & Recall Engine),是一个为大型语言模型(LLM)设计的外部记忆系统。你可以把它想象成一个专属于你的人工智能“数字大脑”。它的核心作用是记录并储存你与各种AI工具的互动历史、个人资料和工作流程,形成一个统一且可移植的记忆库。这样一来,当你使用不同的人工智能应用时,就无需反复提供相同的背景信息。C.O.R.E将这些信息组织成一个相互关联的知识图谱,不仅能记住孤立的事实,还能理解它们之间的联系。最重要的是,这个“数字大脑”完全由你掌控,你可以随时添加、修改、删除其中的内容,并决定是否要将其接入某个AI工具,从而摆脱了被特定平台绑定的困扰。

功能列表

- 统一记忆存储: 将你在不同AI应用(如Claude、Cursor等)中的对话历史、偏好设置和上下文数据集中存储。

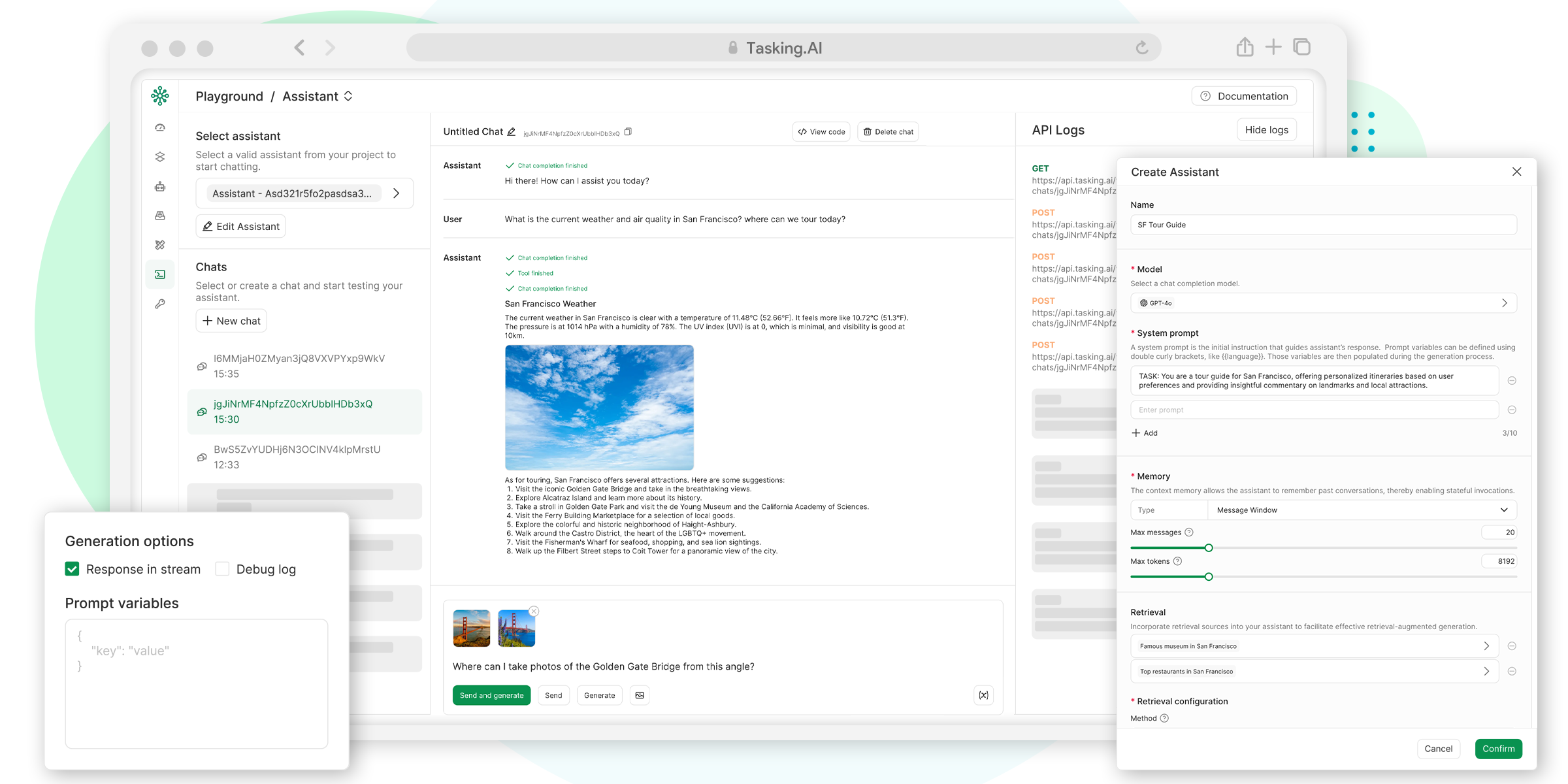

- 记忆图谱可视化: 提供一个仪表盘界面,可以将存储的信息以知识图谱的形式展示出来,让你直观地看到不同信息之间的关联。

- 与记忆对话: 你可以直接向C.O.R.E提问,快速查询和理解已经存储在记忆库中的信息。

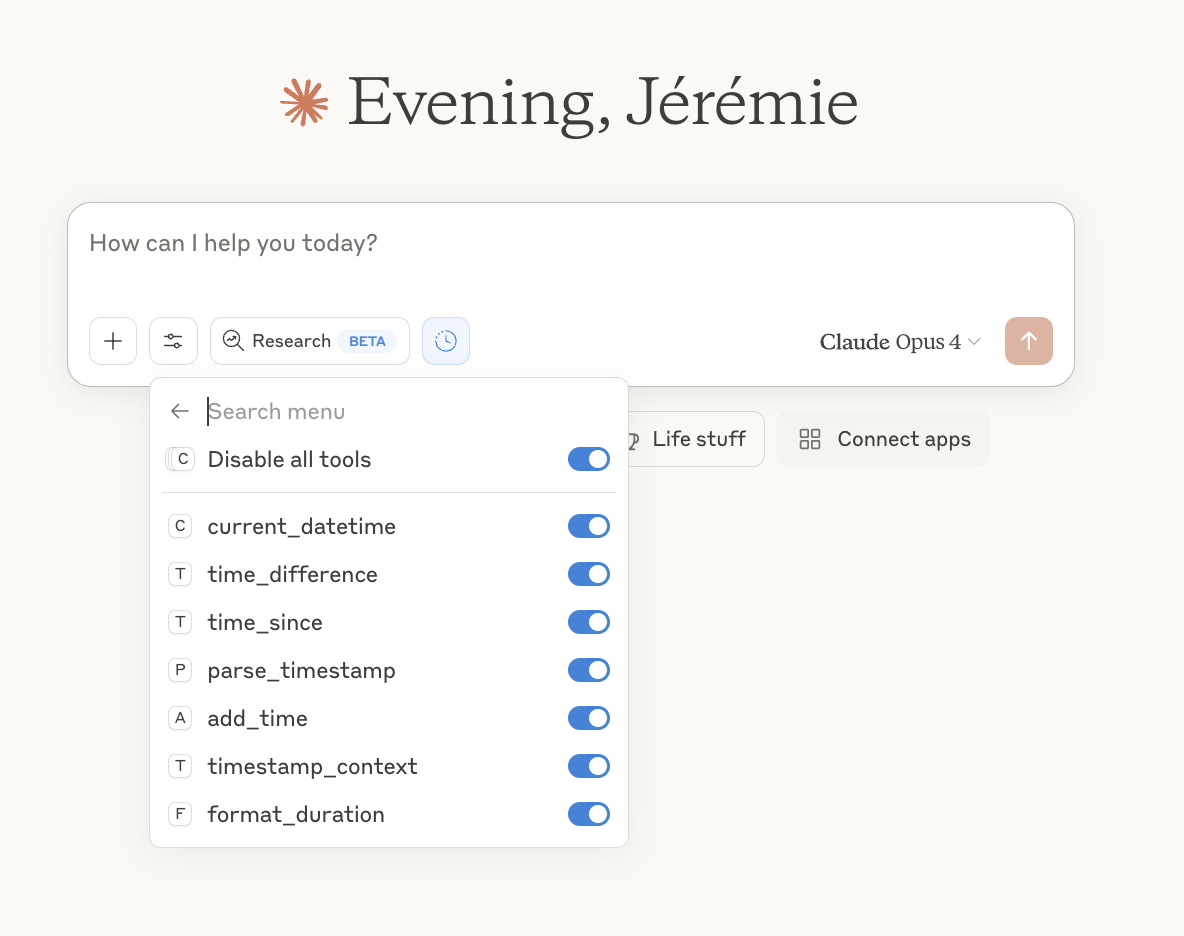

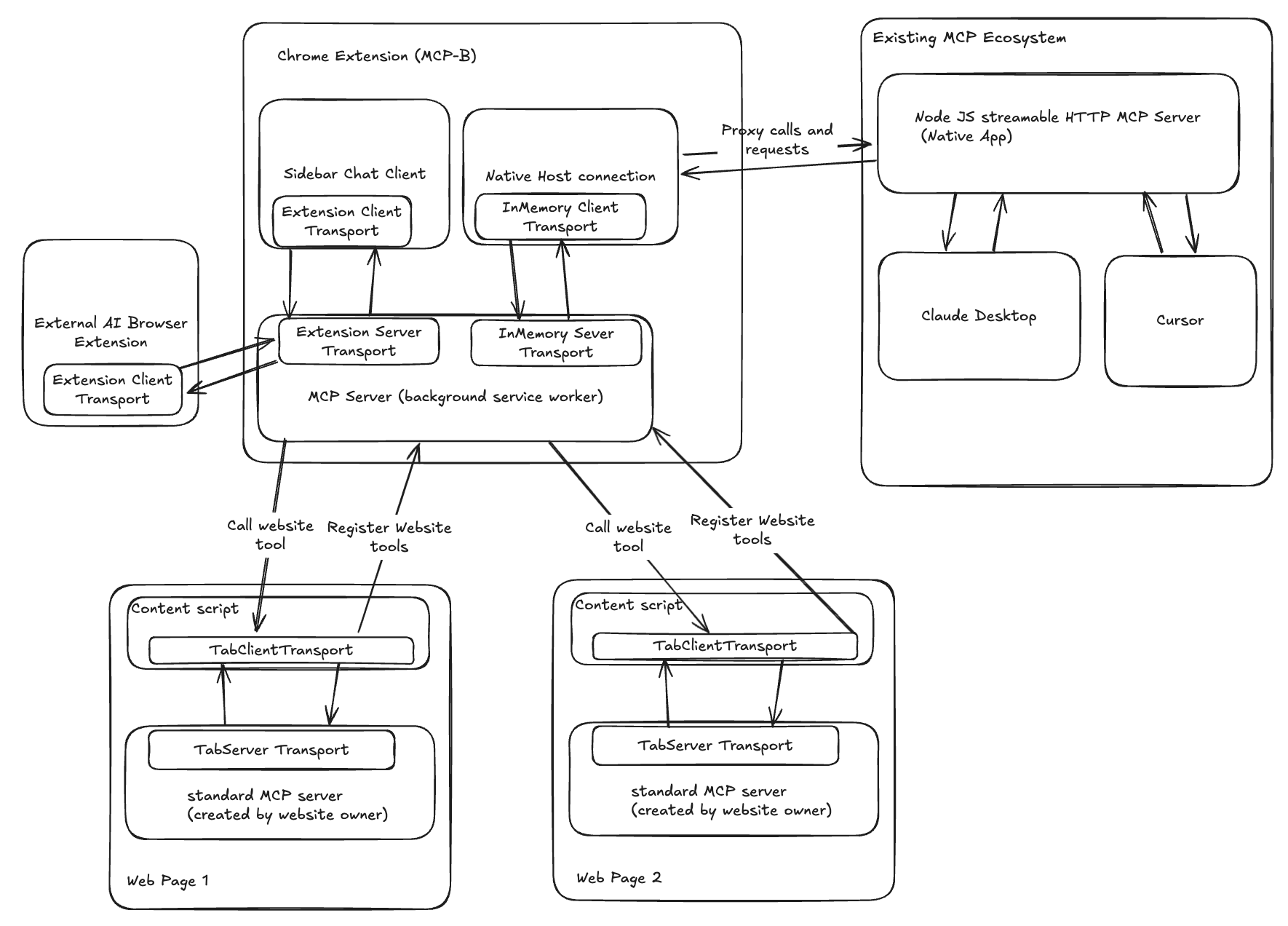

- 即插即用: 可以轻松地与Cursor编辑器等第三方应用集成,让这些应用能够直接调用你的个人记忆库。

- 用户数据主权: 用户拥有对自己数据的完全控制权,可以自主决定数据的存储、修改、删除和共享,避免被单一服务商锁定。

- 本地化部署: 支持使用Docker在个人电脑上进行本地部署,确保数据的私密性。

- 云端服务: 提供官方的云端版本,用户无需自行部署即可快速上手使用。

使用帮助

C.O.R.E提供两种使用方式:云端服务和本地部署。你可以根据自己的需求选择合适的方式来搭建属于你的“数字大脑”。

方式一:使用C.O.R.E云端服务(推荐新手)

这是最简单快捷的方式,无需任何技术背景。

- 注册账户:访问官方网站

core.heysol.ai。 - 开始使用:注册后,你就可以开始在仪表盘中添加你想让AI记住的文本信息。点击“+ Add”按钮,系统会自动处理你的文本并生成记忆图谱。

- 连接到其他工具:你可以参照官方文档,将你的云端记忆库与Cursor等支持的AI应用连接起来。

方式二:在本地电脑上部署C.O.R.E

如果你希望数据完全存储在自己的设备上,可以选择本地部署。这种方式需要一些基础的技术知识。

部署前的准备工作

- 安装 Docker: Docker是一个容器化平台,用于简化应用的部署流程。你需要先在你的电脑上安装Docker。

- 获取 OpenAI API Key: C.O.R.E目前主要使用OpenAI的模型来处理和理解你的数据。你需要一个OpenAI账户并生成一个API密钥。

本地部署操作流程

- 下载项目文件:首先,你需要从GitHub上克隆C.O.R.E的项目文件。打开你的终端(命令行工具),输入以下命令:

git clone https://github.com/RedPlanetHQ/core.git cd core - 配置环境变量:项目需要一个

.env文件来存放你的API密钥等配置信息。你可以直接复制项目中的示例文件。cp .env.example .env然后,使用文本编辑器打开这个新建的

.env文件,找到OPENAI_API_KEY这一行,并将你的OpenAI API密钥填入。 - 启动应用:在项目的根目录下,运行以下Docker Compose命令来启动所有服务(包括Web应用、数据库等)。

docker-compose up终端会开始输出大量的日志信息。当看到类似服务启动成功的提示后,说明C.O.R.E已经成功在你的电脑上运行了。

- 访问和创建账户:

- 打开你的网络浏览器,访问

http://localhost:3000。 - 你会看到一个登录界面。点击“Continue with email”按钮。

- 输入你的电子邮箱地址,然后点击“Send a Magic Link”。

- 此时,不要去邮箱查收邮件。因为是本地部署,验证链接会直接显示在你的终端日志中。回到你刚才运行

docker-compose up的终端窗口,找到一个包含http://localhost:3000/auth/magic-link的链接,复制它。 - 将这个链接粘贴到你的浏览器地址栏中并打开,即可完成账户创建和登录。

- 打开你的网络浏览器,访问

- 添加和查询记忆:

- 登录后,你会看到一个仪表盘。在右上角的输入框中,输入你想要储存的信息,例如:“我喜欢打羽毛球”。

- 点击“+Add”按钮,这条信息会被送到处理队列中。你可以在“Logs”区域查看处理状态。

- 处理完成后,相关的知识节点就会出现在你的私人知识图谱中。

- 你可以使用仪表盘上的搜索功能,随时查询你已经存入的记忆。

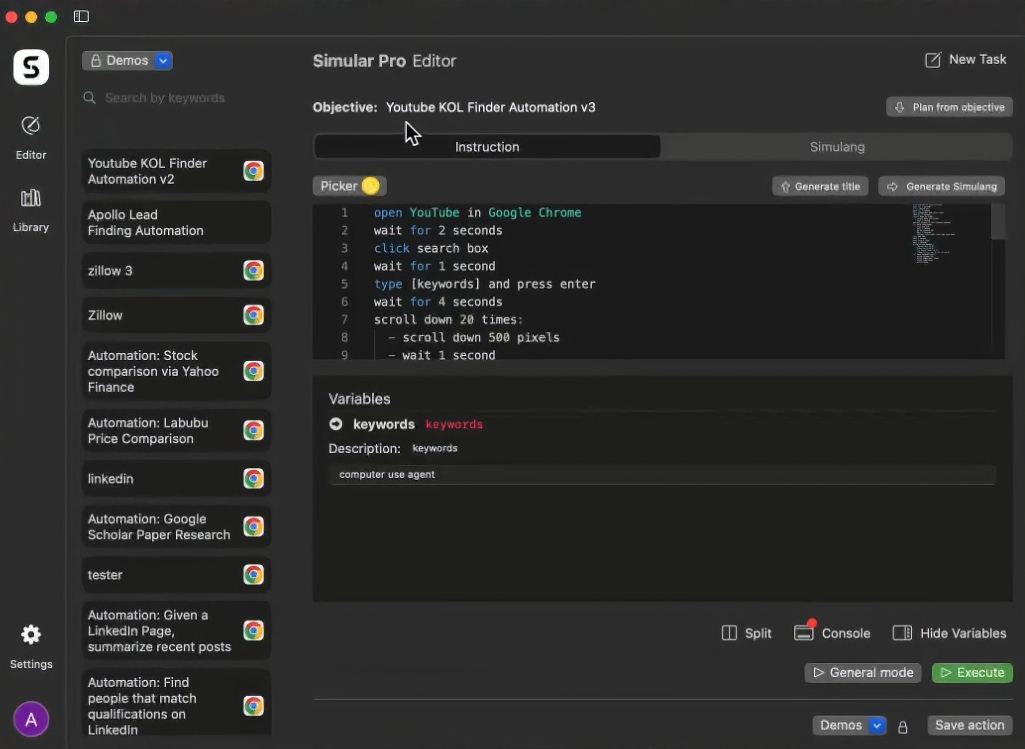

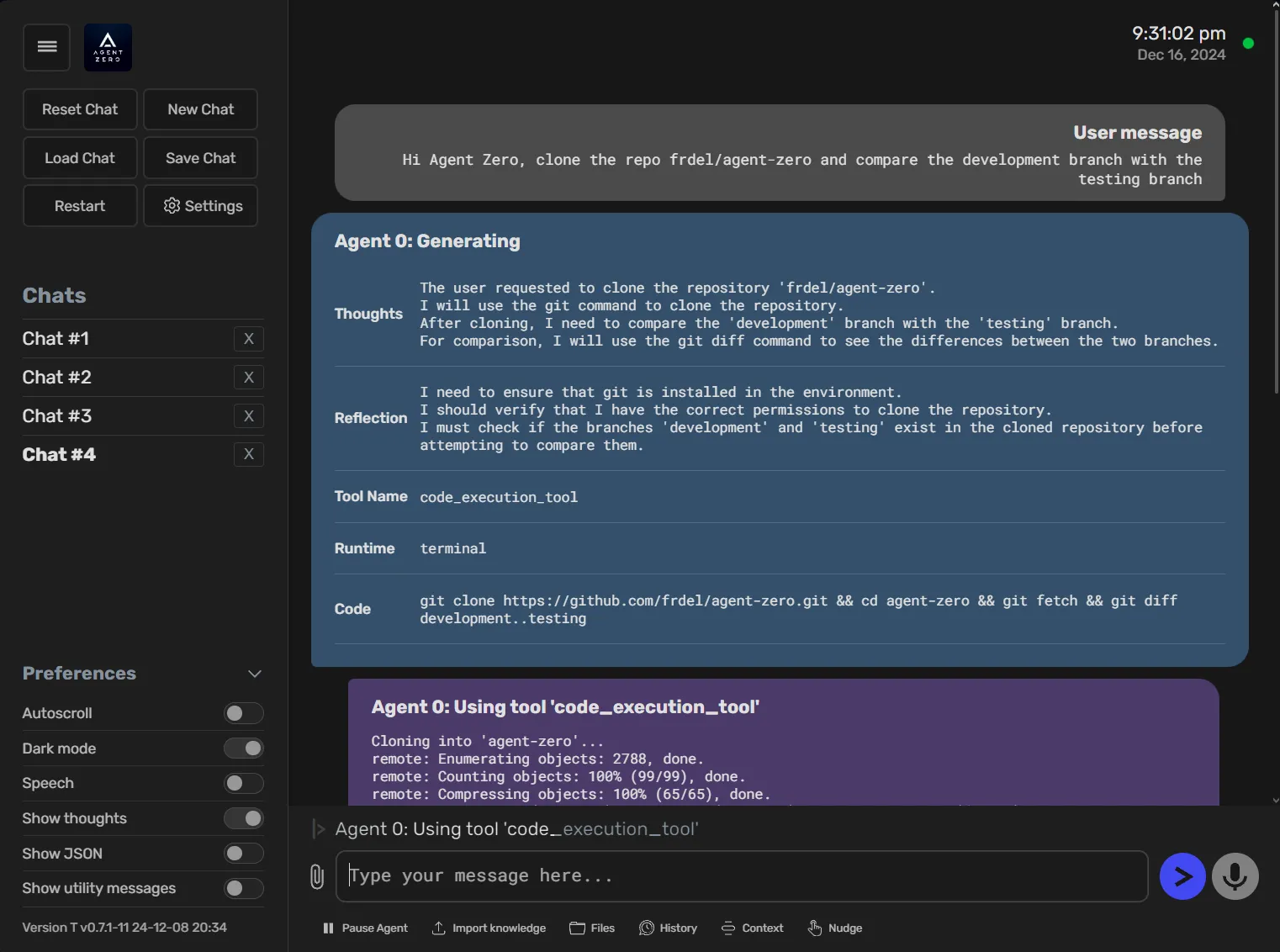

与Cursor编辑器集成

如果你是Cursor编辑器的用户,可以将你的C.O.R.E记忆库集成进去,让AI在编码时能够参考你的个人知识。

- 生成API Token: 在C.O.R.E的仪表盘中,进入

API区域,生成一个新的API Token并复制它。 - 配置Cursor:

- 打开Cursor,进入

Settings→Tools & Integrations→New MCP Server。 - 按照下面的格式添加一个新的MCP服务器配置。记得将

YOUR_API_TOKEN_HERE替换成你刚刚生成的Token。如果你是本地部署,API_BASE_URL应为http://localhost:8000;如果是使用云服务,则为https://core.heysol.ai。

{ "mcpServers": { "memory": { "command": "npx", "args": ["-y", "@redplanethq/core-mcp"], "env": { "API_TOKEN": "YOUR_API_TOKEN_HERE", "API_BASE_URL": "https://core.heysol.ai", "SOURCE": "cursor" } } } } - 打开Cursor,进入

- 设置自动记忆规则:

- 进入

Settings->User rules->New Rule,添加一条规则,让Cursor在每次与AI交互后,自动将问答内容存入C.O.R.E记忆库。

- 进入

应用场景

- 开发者辅助编程开发者可以将常用的代码片段、项目背景、架构设计、个人编码习惯等信息存入C.O.R.E。当使用像Cursor这样的AI编程工具时,AI可以直接从记忆库中获取上下文,提供更贴合项目需求和个人风格的代码建议,无需开发者反复解释项目的技术栈或规范。

- 研究人员与学生管理知识在阅读论文、书籍或进行在线课程学习时,可以将关键概念、文献摘要、实验数据和自己的思考笔记添加到C.O.R.E中。久而久之,它会形成一个与个人知识体系同步的外部大脑。在撰写论文或报告时,可以直接向C.O.R.E提问,快速找到相关的引用和事实依据。

- 跨应用任务处理用户可能在A应用中与AI讨论了一个项目计划,又在B应用中让AI起草邮件。通过C.O.R.E,B应用中的AI可以知晓A应用中的讨论背景,从而起草出内容更精准的邮件,实现了不同AI工具之间的信息同步,打破了应用孤岛。

QA

- C.O.R.E支持哪些大型语言模型?目前C.O.R.E对基于OpenAI的GPT系列模型支持最好。官方正在积极改进对Llama等其他模型的支持,但现阶段使用非OpenAI模型可能无法获得最佳效果。

- 我的数据安全吗?隐私如何保证?C.O.R.E的设计核心之一就是用户数据主权。如果你选择本地部署,所有数据都存储在你自己的电脑上,完全由你控制。 如果使用云服务,请查阅其官方的隐私政策。官方明确建议,不要在C.O.R.E中存储个人身份信息(PII)、密码或系统日志等敏感数据。

- C.O.R.E和普通的笔记软件有什么区别?普通笔记软件通常以文件夹和文档的形式进行线性存储。而C.O.R.E会将你的信息处理成一个知识图谱,它不仅存储信息本身,还分析并存储信息之间的关系。 这让它更像一个真正的大脑,能够进行关联性思考,也更便于AI理解和调用复杂的上下文。

- 使用C.O.R.E需要付费吗?该项目是开源的,你可以在GitHub上免费获取其源代码并进行本地部署。 官方提供的云端服务(C.O.R.E Cloud)可能会有相应的收费计划,具体需要参考其官方网站。