LMArena

综合介绍

LMArena 是一个免费的在线平台,专注于测试和比较不同人工智能模型的表现。用户可以通过互动对话、提交提示或参与投票,直接体验和评估AI模型的能力。平台由加州大学伯克利分校 SkyLab 研究团队创建,现已独立于 LMSYS.org,致力于通过社区参与推动AI研究。LMArena 支持多种AI模型,涵盖文本、图像等多种模态,并提供实时排行榜,展示模型性能。用户可以免费访问,操作简单,适合研究人员、开发者或对AI感兴趣的普通用户。平台通过超过350万个用户投票生成可靠的排行数据,确保评估结果公开透明。

功能列表

- 模型互动测试:用户可以与多种AI模型进行实时对话,测试其回答质量和逻辑性。

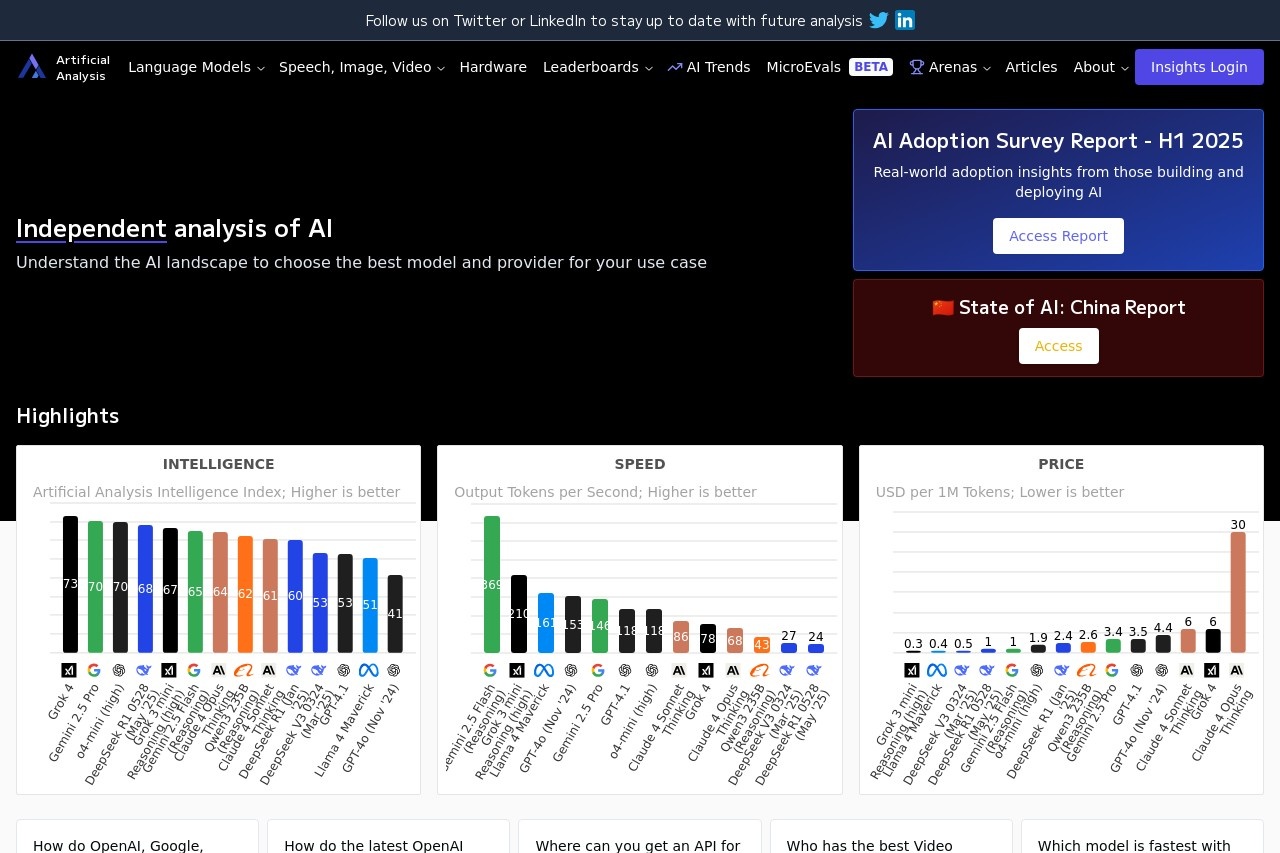

- 排行榜查看:提供基于用户投票的Elo评分排行榜,展示不同AI模型的性能表现。

- 自定义提示测试:支持用户输入特定提示,生成针对性排行榜,评估模型在特定任务上的表现。

- 多模态支持:不仅限于文本模型,还支持图像生成和处理等功能,未来将扩展更多模态。

- 搜索增强测试:通过 Search Arena 功能,测试AI模型在检索、写作、调试等任务中的表现。

- 社区投票参与:用户可参与模型表现的众包评估,投票结果影响排行榜。

- 开源支持:提供 GitHub 仓库,公开部分代码和数据集,供开发者参考和贡献。

使用帮助

LMArena 的使用非常直观,用户无需安装任何软件,直接通过浏览器访问 https://lmarena.ai/ 即可开始。以下是详细的使用指南,帮助用户快速上手。

访问与注册

- 打开浏览器,输入

https://lmarena.ai/,进入 LMArena 官网。 - 无需注册即可使用大部分功能。直接点击首页的“开始聊天”或“查看排行榜”按钮,进入核心功能页面。

- 如果需要保存聊天记录或参与社区投票,建议注册账号。点击右上角“注册”按钮,输入邮箱和密码即可完成注册,过程不到一分钟。

核心功能操作

1. 模型互动测试

LMArena 的核心功能是与不同AI模型进行实时对话,测试其表现。操作步骤如下:

- 在首页选择“聊天”选项,进入聊天界面。

- 界面会显示多个AI模型(如 GPT、Gemini、Vicuna 等)。选择一个或多个模型进行对话。

- 在输入框中输入问题或任务,例如“解释量子力学”或“写一首诗”。点击“发送”后,模型会实时生成回答。

- 用户可以比较不同模型的回答,查看其逻辑性、准确性和语言流畅度。

- 特色功能:支持并行测试,多个模型同时回答同一问题,方便直观比较。

2. 查看排行榜

LMArena 提供基于 Elo 评分的排行榜,展示AI模型的相对表现。操作步骤:

- 点击首页“排行榜”按钮,进入

lmarena.ai/leaderboard。 - 排行榜显示模型名称、Elo 分数、任务类型(如文本生成、检索等)等信息。

- 用户可以按任务类型筛选,例如查看专门的“图像生成”或“代码调试”排行榜。

- 点击具体模型,查看详细统计数据,如用户投票数和胜率。

- 提示:排行榜每周更新,数据来自超过350万次用户投票,准确性高。

3. 自定义提示测试(P2L)

Prompt-to-Leaderboard(P2L)功能允许用户输入特定提示,生成定制化的模型排行榜。操作方法:

- 在首页选择“P2L”功能,进入提示输入页面。

- 输入自定义提示,例如“为电商网站写产品描述”或“解决Python调试问题”。

- 系统会自动调用多个AI模型处理提示,并根据表现生成临时排行榜。

- 用户可以查看每个模型的回答质量和评分,适合需要特定任务评估的开发者或企业用户。

- 注意:此功能需要稳定的网络连接,生成时间可能因提示复杂性而异。

4. Search Arena 测试

Search Arena 是 LMArena 的特色功能,用于测试AI模型在搜索增强任务中的表现。操作步骤:

- 进入“Search Arena”页面,点击“开始测试”。

- 选择任务类型,如“实时信息检索”“代码调试”或“文章写作”。

- 输入具体任务,例如“查找2025年最新科技趋势”或“修复一段Python代码”。

- 系统会调用支持搜索的模型(如 Perplexity、Gemini),生成结果并比较表现。

- 用户可以查看每个模型的检索速度、答案准确性和格式清晰度。

- 优势:Search Arena 模拟真实场景,适合测试AI在动态任务中的能力。

5. 参与社区投票

LMArena 依靠社区投票生成排行榜,用户可以参与评估。操作方法:

- 在聊天或测试页面,完成模型测试后,系统会提示“为回答评分”。

- 选择你认为表现更好的模型,或标记回答为“平局”。

- 提交投票后,系统会记录结果并更新排行榜。

- 注意:投票需遵守平台规则,避免恶意刷票。用户提交的对话可能公开,用于研究和改进AI。

其他功能

- 多模态支持:除了文本,LMArena 支持图像生成测试。用户可以上传图片或描述生成图像,比较不同模型的图像质量。

- 移动优化:平台支持手机浏览器访问,界面适配良好,适合随时随地测试AI。

- 开源资源:访问 LMArena 的 GitHub 页面(

github.com/lmarena),查看公开代码和数据集,开发者可参与贡献。

注意事项

- 隐私:用户提交的对话和提示可能公开用于研究。不要输入敏感信息。

- 网络要求:部分功能(如 Search Arena)需要高速网络以确保实时性。

- 更新频率:排行榜和模型库定期更新,建议关注 LMArena 的 X 账号(@lmarena_ai)获取最新动态。

应用场景

- AI研究与开发研究人员和开发者可以利用 LMArena 测试不同模型在特定任务中的表现,获取数据支持论文或项目开发。

- 教育与学习学生和教师可以通过对话测试,了解AI模型的逻辑推理能力,辅助学习编程、写作或科学知识。

- 企业选型企业用户可以使用 P2L 功能,测试AI模型在特定业务场景(如客服、营销文案)的表现,选择最适合的模型。

- 兴趣探索对AI感兴趣的普通用户可以通过 LMArena 体验最新模型,参与社区投票,了解AI技术发展趋势。

QA

- LMArena 是否需要付费?LMArena 完全免费,用户无需付费即可使用聊天、排行榜和测试功能。

- 如何确保排行榜的公平性?排行榜基于超过350万次用户投票,采用 Elo 评分系统,数据公开透明,定期更新。

- 可以测试哪些类型的AI模型?支持文本生成、图像生成、搜索增强等多种模型,未来将扩展更多模态。

- 我的对话数据会公开吗?用户提交的对话可能用于研究并公开,建议不要输入敏感信息。

- 如何参与平台开发?访问

github.com/lmarena,查看开源代码,提交贡献或反馈问题。